Skapa en datumtabell i LuckyTemplates

Ta reda på varför det är viktigt att ha en dedikerad datumtabell i LuckyTemplates och lär dig det snabbaste och mest effektiva sättet att göra det.

I den här bloggen kommer vi att diskutera textanalys i Python för att skapa konstruerad data från textinnehåll. Detta kommer att hjälpa dig att analysera stora mängder data och förbruka mindre tid på att arbeta med vissa uppgifter. Du kommer också att få kunskap om textblob som behandlar naturliga språkbearbetningsuppgifter.

Textanalys är processen att analysera texter genom att använda koder för automatiserade processer för att producera och gruppera textdata.

Innan vi fortsätter kan du behöva installera biblioteket som vi kommer att använda i den här handledningen.

Innehållsförteckning

Implementera textanalys i Python

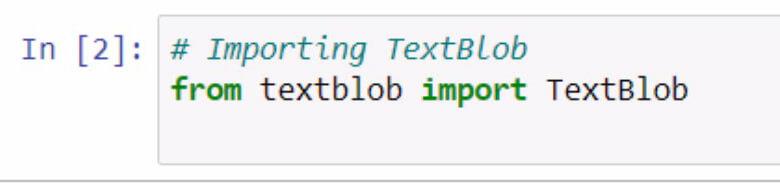

Låt oss börja med att importera textblob . Kom ihåg att dokumentera vad du gör med användningen av kommentarer.

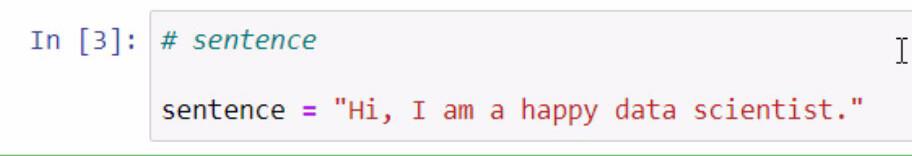

Genom att köra koden ovan har vi nu tillgång till textblob -biblioteket. Nästa steg vi ska göra är att skapa en mening som vi ska använda för våra exempel. Vi ska göra detta genom att lagra en mening i en variabel som heter mening .

Kom ihåg att omge meningen som du vill lägga till med dubbla citattecken.

Textblobben är ett fantastiskt bibliotek där vi kan skapa en blob och använda några av dess funktioner för vår textanalys i .

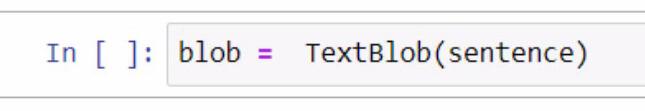

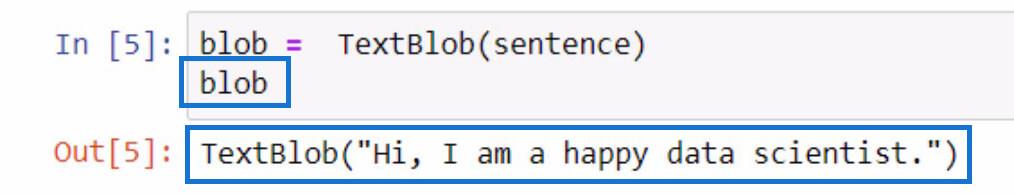

När vi skapar bloben börjar vi med att skapa en variabel och namnge den blob . I den här variabeln måste vi lägga till TextBlob som är biblioteket som vi använder.

Inom parentesen kommer vi att använda meningsvariabeln som innehåller meningen som vi skapade tidigare. Observera att du kan välja att manuellt skriva själva meningen inom parentesen för den här delen.

För att kontrollera vad denna blobvariabel gör kan du helt enkelt initiera den genom att skriva variabelnamnet och trycka på Shift + Enter-tangenterna. Utdata ska likna exemplet nedan.

Som du kan se av resultatet är meningen som vi lagrade i meningsvariabeln nu innehållen av TextBlob .

Tokenisera textdata i Python

Om du vill ta bort några ord i en mening kan vi dela upp vart och ett av dessa ord i enskilda delar i en lista. Med denna givna mening, vad vi ska göra är att symbolisera dem eller separera varje ord och sätta det i en lista.

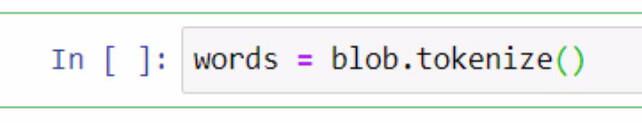

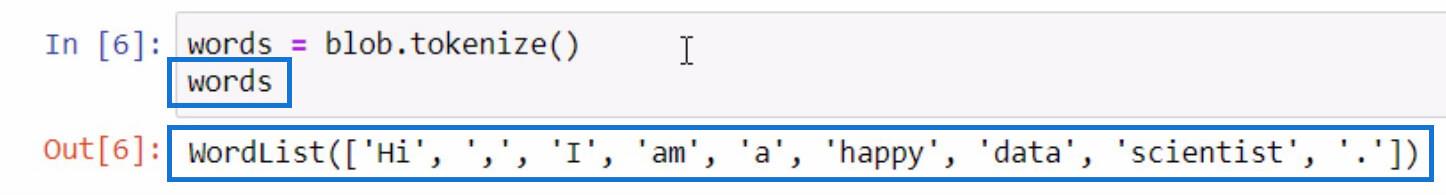

För att göra detta kommer vi att använda variabeln blob och använda tokenize -funktionen. Sedan lagrar vi det i en variabel med namnet ord .

Låt oss initiera ordvariabeln på samma sätt som vi gjorde när vi initierade blobvariabeln för att se vad som finns i den tokeniserade listan.

Som du kan se är vart och ett av orden, och även skiljetecken, nu separerade i en lista. Så här fungerar tokenize- funktionen.

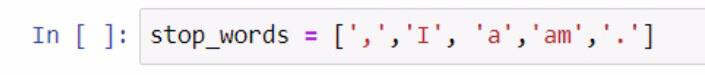

Nu när vi har en lista med ord kan vi sedan utföra en annan funktion från den. Låt oss skapa en annan lista med ord som vi inte vill ska inkluderas i vår lista som skiljetecken och artiklar. För att utföra detta steg, se skärmdumpen nedan.

När vi skapade listan med stoppord använde vi parenteser för att omsluta listan med stoppord. Sedan omges varje stoppord med enstaka citattecken och vart och ett avgränsas med ett kommatecken. Vi lagrade listan i variabeln stop_words .

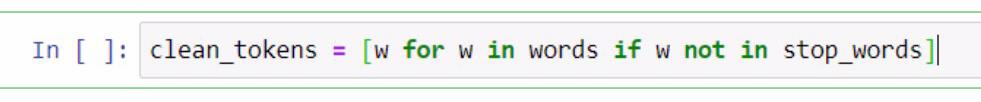

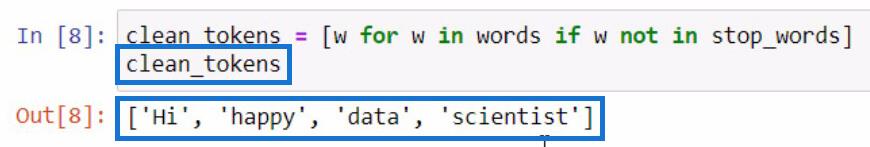

Härifrån kommer vi att utföra en listförståelse för att ta bort ord som är nödvändiga för att utföra textanalys i . Detta inkluderar rengöring av meningar, tokenisering och jämförelse av olika listor. Vi ska nu jämföra dessa två listor och skapa en ny lista med clean_tokens .

I koden som presenteras ovan använde vi en platshållare som är w för att representera ett element . Vad vi försöker göra i den här delen är att få elementet i ordvariabeln om elementet inte finns i stop_words- variabeln. Om vi ska initiera clean_tokens kommer detta att bli resultatet.

I den här processen kan vi rengöra våra tokens genom att lägga in en process för att ta bort onödiga tokens som skiljetecken och artiklar. På grund av det har vi bara essensorden kvar på vår lista.

Gå med tokens för att bilda en mening i Python

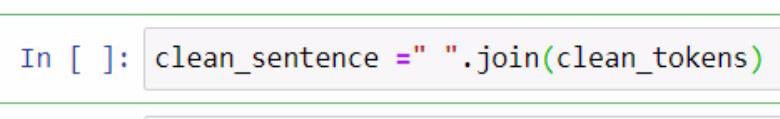

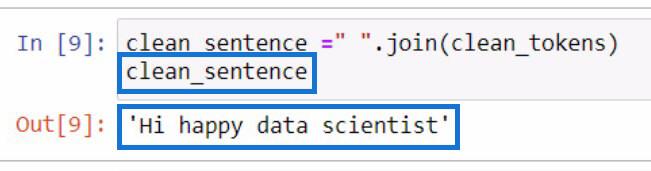

Nu när vi har separerat de rena tokens , låt oss försöka lägga dem helt i en mening. För att göra det måste vi använda .join- funktionen. Se exemplet nedan för referens.

I exemplet ovan skapade vi en variabel som heter clean_sentence för att hålla våra rena tokens som kommer att kombineras till en mening. Du kan också märka att vi har lagt till ett mellanslag omgivet av dubbla citat och funktionen .join . Inuti parametrarna inkluderade vi variabeln clean_tokens .

Detta blir resultatet om vi initierar variabeln clean_sentence .

Märkbart att meningen inte ser rätt ut eftersom vi tog bort artiklarna och skiljetecken tidigare.

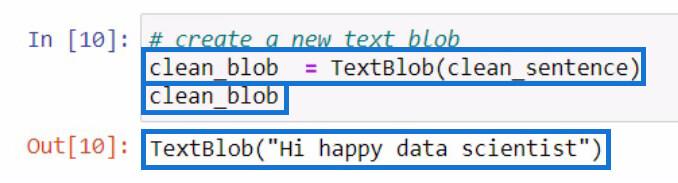

Efter att ha skapat clean_sentence , låt oss försöka skapa en ny textblob som innehåller clean_sentence som vi just skapade. Sedan lagrar vi det i en ny variabel clean_blob .

Dissekera en textklump för delar av tal med hjälp av .tags-funktionen

Från den här analysblobben kan vi använda bitarna av denna blob för att leta efter orddelar eller göra ännu fler ändringar. Låt oss försöka kontrollera orddelarna för varje ord i vår nya textblob .

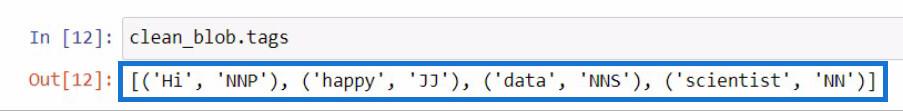

För att kontrollera orddelarna i en textblob bör du använda .tags -funktionen. Jag gjorde detta genom att använda vår clean_blob- variabel och sedan lade jag till .tags -funktionen direkt efter.

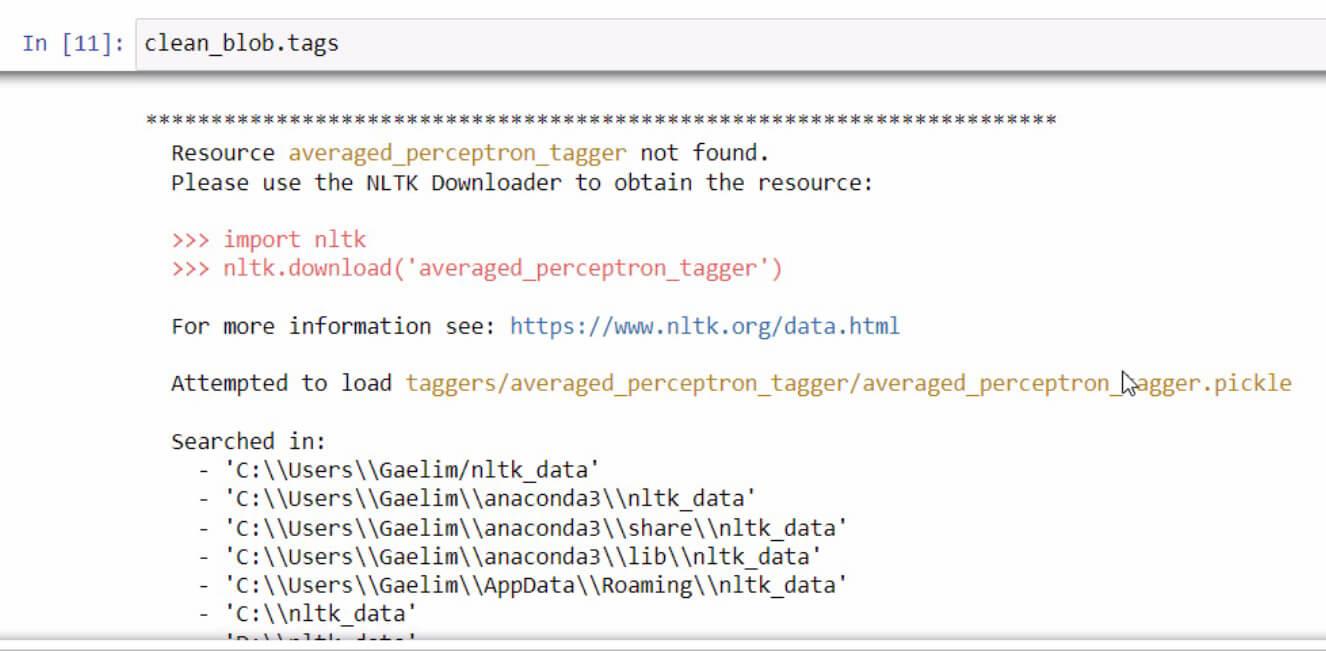

Om du någonsin får ett felmeddelande när du initierar .tags -funktionen, läs bara och följ stegen för att åtgärda felet. I det här fallet ser det ut så här.

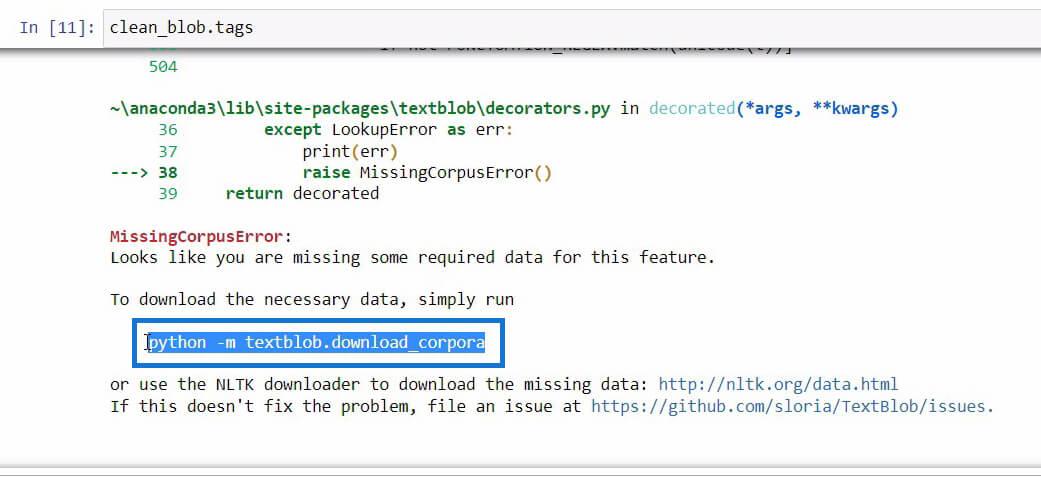

Om du rullar nedåt i slutet av det här felmeddelandet ser du den nödvändiga informationen som du behöver för funktionen som du försöker använda.

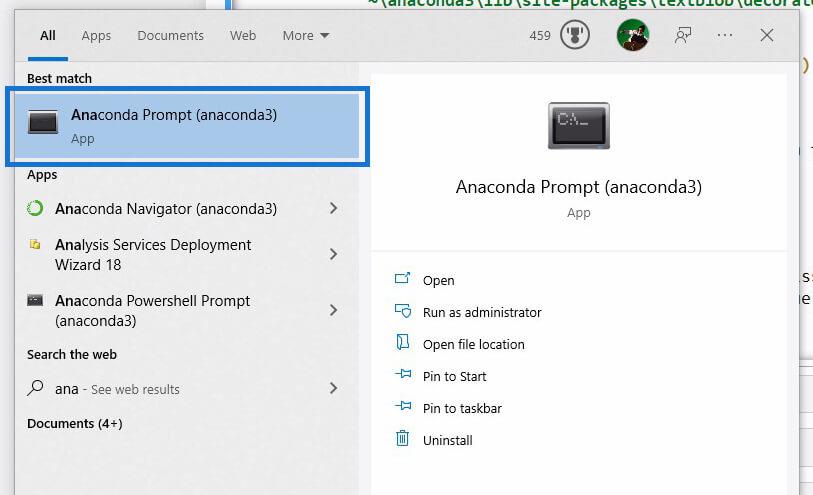

När vi har hittat koden som vi behöver initialisera för att ladda ner nödvändiga data, kopiera bara koden och öppna sedan med Windows Search .

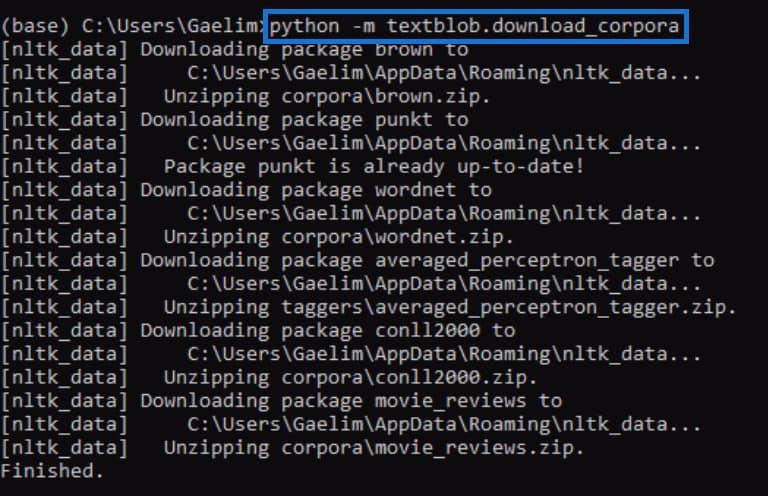

Med hjälp av Anaconda Prompt försöker vi åtgärda felet som vi fick när vi initierade .tags -funktionen. Vi kommer nu att klistra in koden som vi kopierade från felmeddelandet tidigare och köra den genom att trycka på Enter .

När det är klart, försök att köra .tags- funktionen igen och se om det fungerar.

När vi kör koden igen kan vi se att felet är åtgärdat och vi fick ett resultat som innehåller varje ord från den nya textblobben tillsammans med taggarna eller delar av tal.

Om du inte har någon aning om vad dessa taggar betyder, kan du helt enkelt gå till textblobs webbplats för att kontrollera vad dessa taggar representerar.

Använda ngrams-funktionen för textanalys i Python

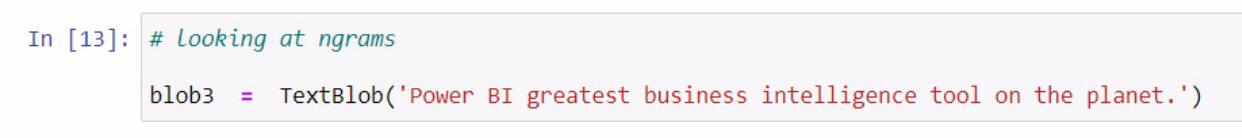

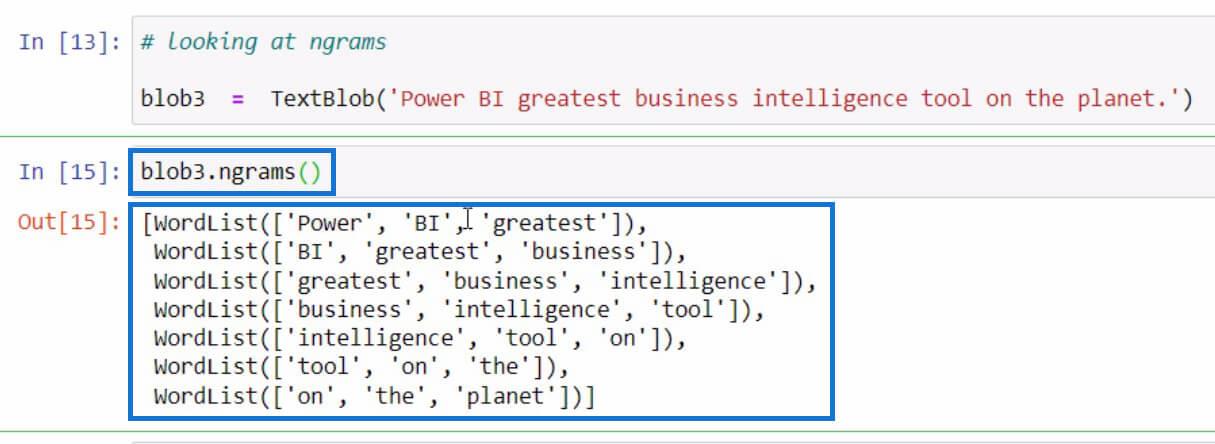

Låt oss gå till ett annat exempel, som handlar om att få ngrams . Funktionen ngrams används för att leta efter ord som ofta ses tillsammans i en mening eller ett dokument. Som ett exempel, låt oss börja med att skapa en ny textblob och lagra den i variabeln blob3 .

Efter det, låt oss använda ngrams -funktionen i variabeln blob3 för att kontrollera några kombinationer av ord.

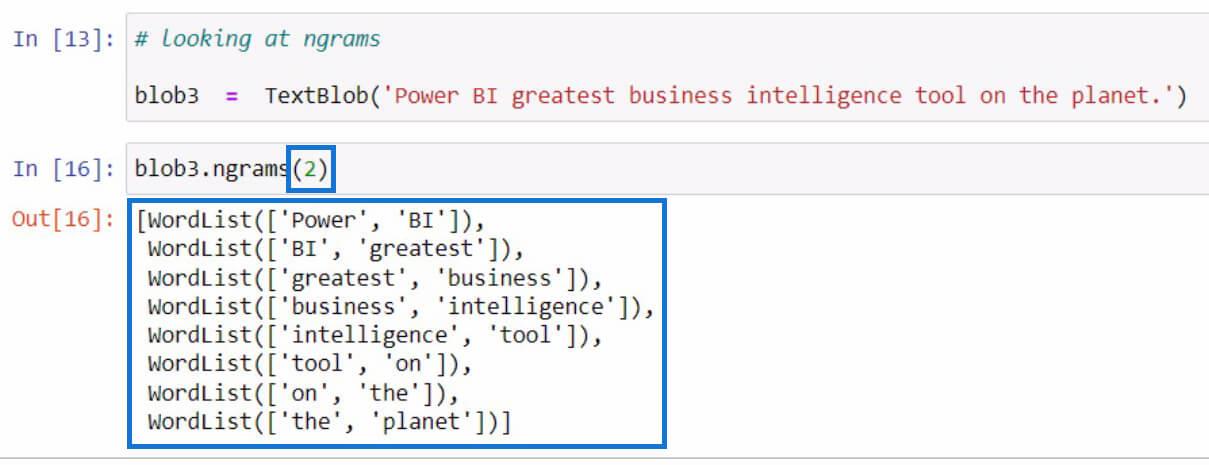

Som standard, om du inte angav ett värde i parametrarna, kommer det att visa trigram eller 3-ordskombinationer. Men om vi vill se 2-ordskombinationer från meningen kan vi ställa in 2 i parametrarna som i exemplet nedan.

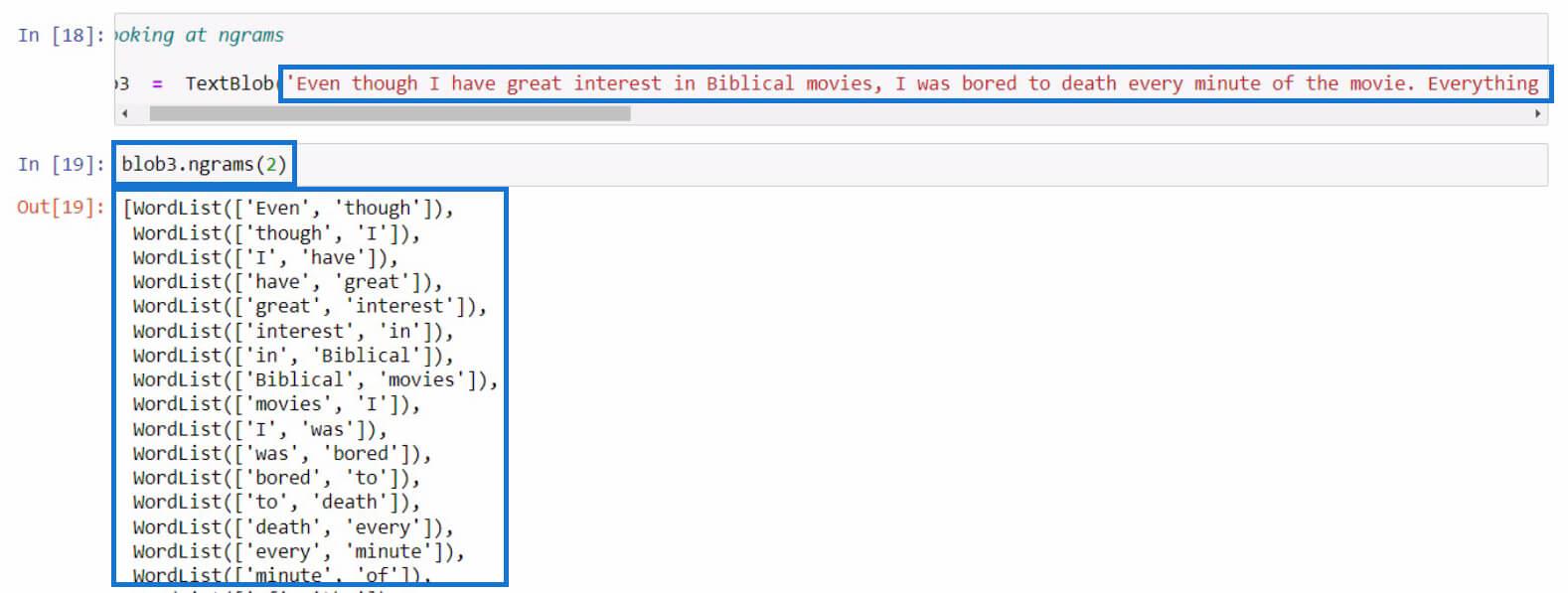

Låt oss försöka med en längre mening den här gången. I det här exemplet kopierade jag bara en längre text från en filmrecension. Du kan använda vilken mening du vill för den här delen.

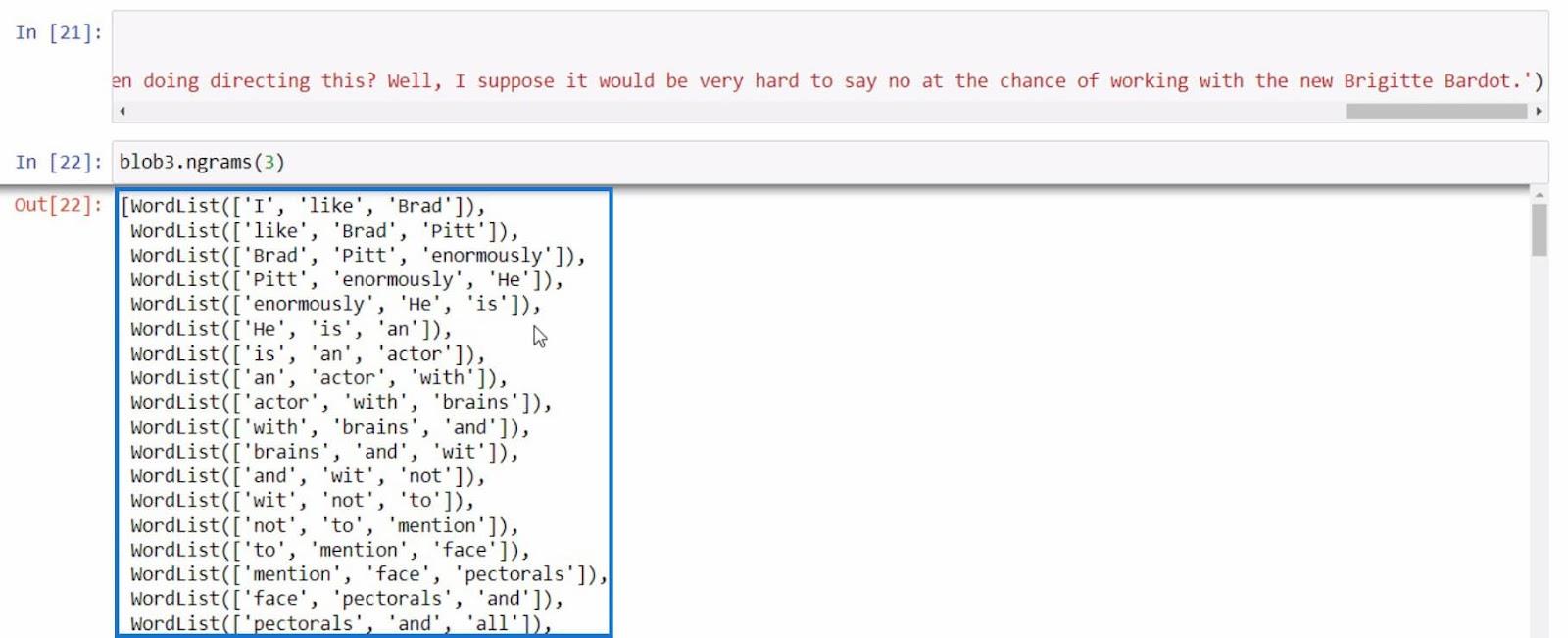

Som ett sista exempel, låt oss försöka använda ngrams en gång till med en mer informativ mening.

Med alla dessa exempel kan vi utföra mer text baserat på resultaten som vi får med ngrams -funktionen.

Slutsats

Sammanfattningsvis har du lärt dig om de olika funktionerna som du kan använda för att utföra textanalys i Python.

Dessa är .tokenize-funktionen för att separera ord i en mening, .join-funktionen för att kombinera tokeniserade ord, .tags-funktionen för att kontrollera orddelarna i ord och ngrams-funktionen för att se kombinationen av ord.

Dessutom har du lärt dig hur du åtgärdar fel som det vi gjorde i .tags -funktionen med hjälp av Anaconda Prompt . Du har också lärt dig hur du importerar, skapar en textblob och använder det här biblioteket för att utföra textanalys i .

Med vänliga hälsningar,

Gaellim

Ta reda på varför det är viktigt att ha en dedikerad datumtabell i LuckyTemplates och lär dig det snabbaste och mest effektiva sättet att göra det.

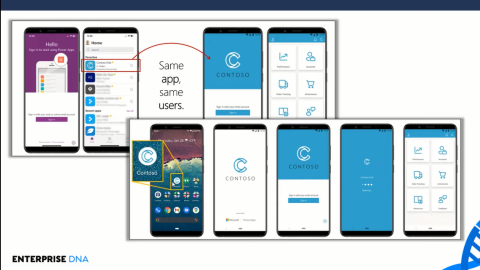

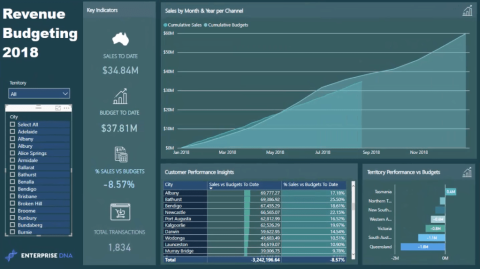

Denna korta handledning belyser LuckyTemplates mobilrapporteringsfunktion. Jag ska visa dig hur du kan utveckla rapporter effektivt för mobila enheter.

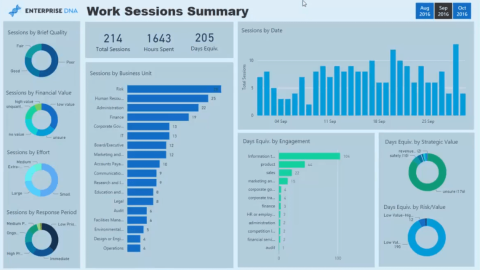

I denna LuckyTemplates Showcase går vi igenom rapporter som visar professionell serviceanalys från ett företag som har flera kontrakt och kundengagemang.

Gå igenom de viktigaste uppdateringarna för Power Apps och Power Automate och deras fördelar och konsekvenser för Microsoft Power Platform.

Upptäck några vanliga SQL-funktioner som vi kan använda som sträng, datum och några avancerade funktioner för att bearbeta eller manipulera data.

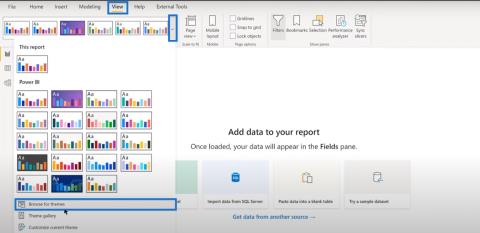

I den här handledningen kommer du att lära dig hur du skapar din perfekta LuckyTemplates-mall som är konfigurerad efter dina behov och preferenser.

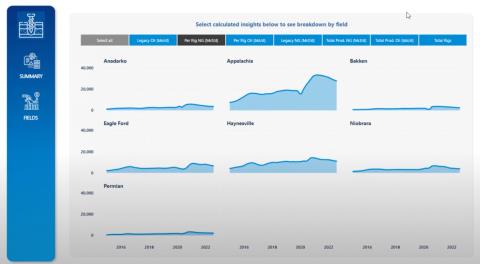

I den här bloggen kommer vi att visa hur man lager fältparametrar med små multiplar för att skapa otroligt användbara insikter och bilder.

I den här bloggen kommer du att lära dig hur du använder LuckyTemplates ranknings- och anpassade grupperingsfunktioner för att segmentera en exempeldata och rangordna den enligt kriterier.

I den här handledningen kommer jag att täcka en specifik teknik kring hur man visar Kumulativ total endast upp till ett specifikt datum i dina bilder i LuckyTemplates.

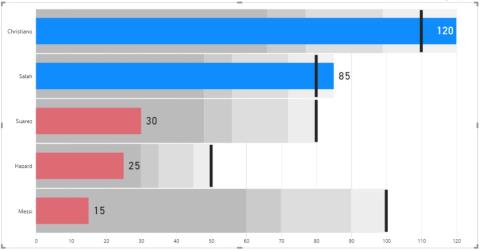

Lär dig hur du skapar och anpassar punktdiagram i LuckyTemplates, som huvudsakligen används för att mäta prestanda mot mål eller tidigare år.