I denne blog vil vi diskutere tekstanalyse i Python for at skabe konstruerede data fra tekstindhold. Dette vil hjælpe dig med at analysere store mængder data og bruge mindre tid på at arbejde med bestemte opgaver. Du vil også tilegne dig viden om tekstblob , der omhandler naturlige sprogbehandlingsopgaver.

Tekstanalyse er processen med at analysere tekster ved at bruge koder til automatiserede processer til fremstilling og gruppering af tekstdata.

Før vi fortsætter, skal du muligvis installere det bibliotek, som vi skal bruge i denne vejledning.

Indholdsfortegnelse

Implementering af tekstanalyse i Python

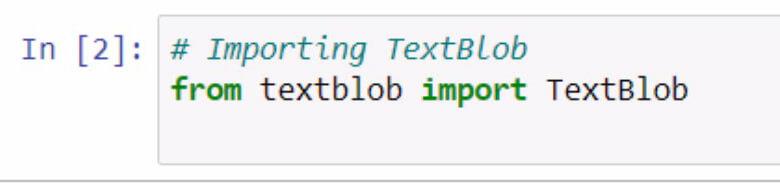

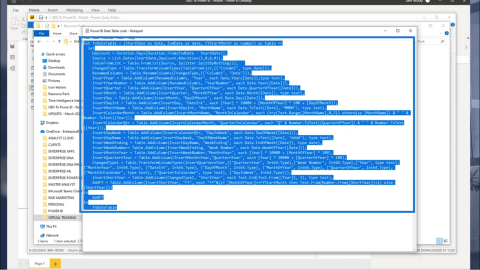

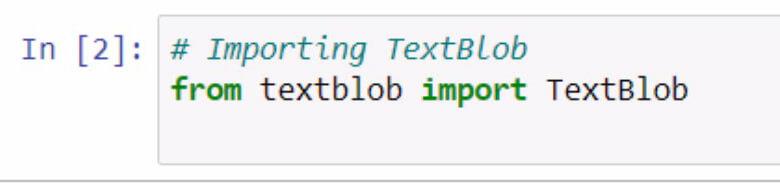

Lad os begynde med at importere textblob . Husk at dokumentere, hvad du laver med brugen af kommentarer.

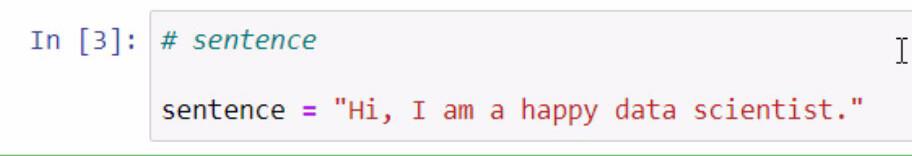

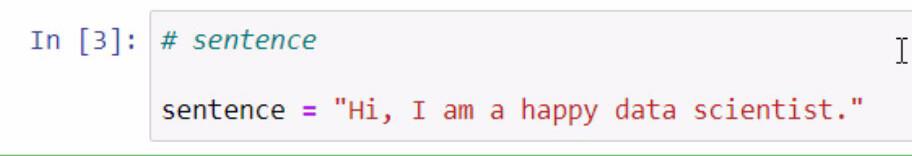

Ved at køre koden ovenfor har vi nu adgang til textblob- biblioteket. Det næste skridt, vi skal gøre, er at lave en sætning, som vi skal bruge til vores eksempler. Vi vil gøre dette ved at gemme en sætning i en variabel med navnet sætning .

Husk at omsætte den sætning, du vil tilføje, med dobbelte anførselstegn.

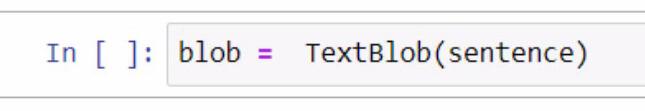

Textblobben er et fantastisk bibliotek, hvor vi kan oprette en klat og bruge nogle af dens funktioner til vores tekstanalyse i .

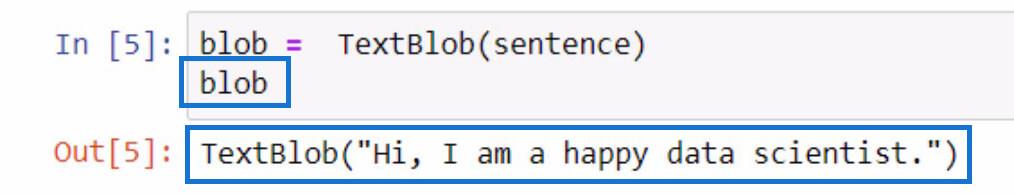

Når vi opretter klatten, starter vi med at oprette en variabel og navngive den blob . I denne variabel skal vi tilføje TextBlob , som er det bibliotek, vi bruger.

Indenfor parenteserne bruger vi sætningsvariablen , som indeholder sætningen, som vi oprettede tidligere. Bemærk, at du kan vælge at skrive selve sætningen manuelt inde i parentesen for denne del.

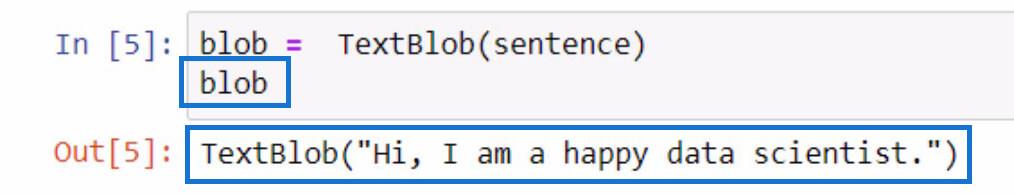

For at kontrollere, hvad denne blob- variabel gør, kan du blot initialisere den ved at skrive variabelnavnet og trykke på Shift + Enter-tasterne. Outputtet skal svare til eksemplet nedenfor.

Som du kan se af resultatet, er sætningen, som vi gemte i sætningsvariablen, nu indeholdt af TextBlob .

Tokenisering af tekstdata i Python

Hvis du vil fjerne nogle ord i en sætning, kan vi adskille hvert af disse ord i individuelle dele på en liste. Med denne givne sætning er det, vi skal gøre, tokenisere dem eller adskille hvert ord og sætte det på en liste.

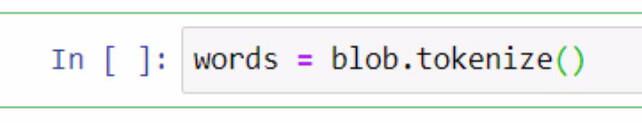

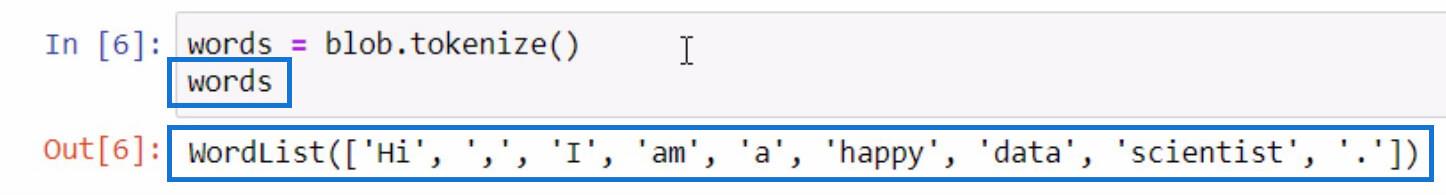

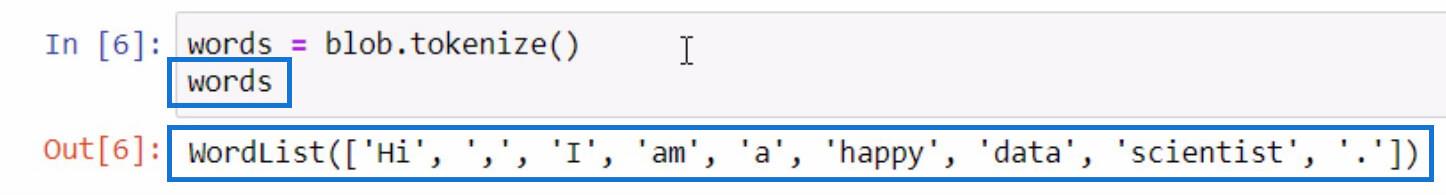

For at gøre dette skal vi bruge blob- variablen og bruge tokenize- funktionen. Derefter gemmer vi det i en variabel med navnet ord .

Lad os initialisere ordvariablen på samme måde, som vi gjorde ved initialisering af blob- variablen for at se, hvad der er på den tokeniserede liste.

Som du kan se, er hvert af ordene og endda tegnsætningstegnene nu adskilt i en liste. Sådan fungerer tokenize- funktionen.

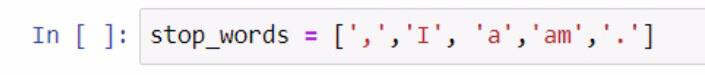

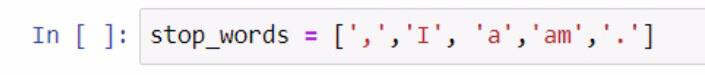

Nu hvor vi har en liste med ord, kan vi så udføre en anden funktion fra den. Lad os oprette en anden liste over ord, som vi ikke ønsker skal inkluderes på vores liste, såsom tegnsætninger og artikler. For at udføre dette trin, se skærmbilledet nedenfor.

Ved oprettelsen af listen over stopord brugte vi parenteser til at omslutte listen over stopord. Derefter er hvert af stopordene omgivet af enkelte anførselstegn, og hver er adskilt af et komma. Vi gemte listen i variabelen stop_words .

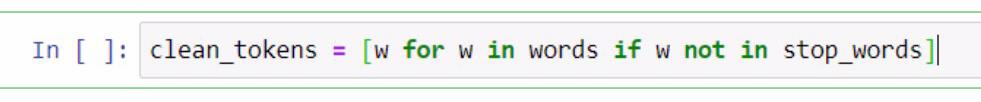

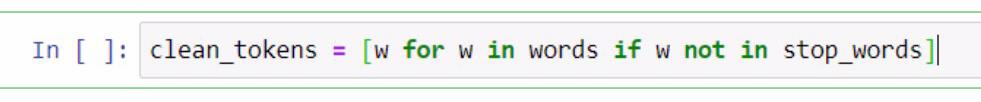

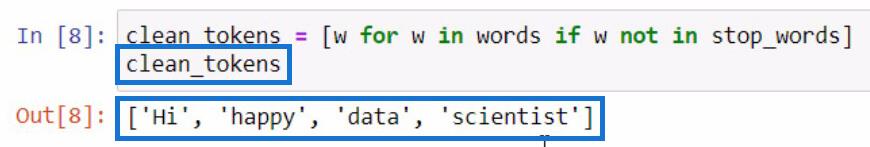

Herfra skal vi udføre en listeforståelse for at fjerne ord, der er nødvendige for at udføre tekstanalyse i . Dette inkluderer rengøring af sætninger, tokenisering og sammenligning af forskellige lister. Vi vil nu sammenligne disse to lister og oprette en ny liste over clean_tokens .

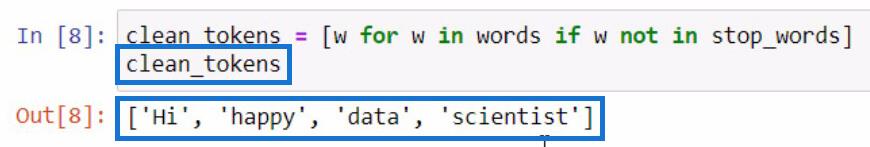

I koden præsenteret ovenfor brugte vi en pladsholder, som er w for at repræsentere et element . Det, vi forsøger at gøre i denne del, er at få elementet i ord-variablen, hvis elementet ikke findes i stop_words- variablen. Hvis vi skal initialisere clean_tokens , vil dette være resultatet.

I denne proces er vi i stand til at rense vores tokens ved at indsætte en proces med at fjerne unødvendige tokens såsom tegnsætninger og artikler. På grund af det har vi kun essensordene tilbage på vores liste.

At slutte sig til tokens for at danne en sætning i Python

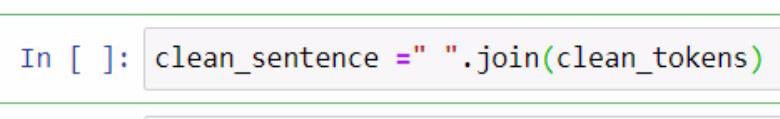

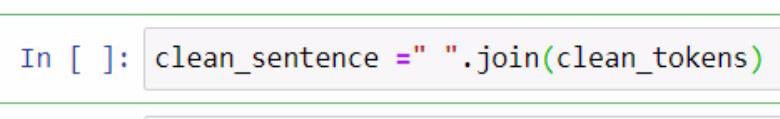

Nu hvor vi har adskilt de rene tokens , lad os prøve at sætte dem sammen i én sætning. For at gøre det skal vi bruge .join- funktionen. Se eksemplet nedenfor for reference.

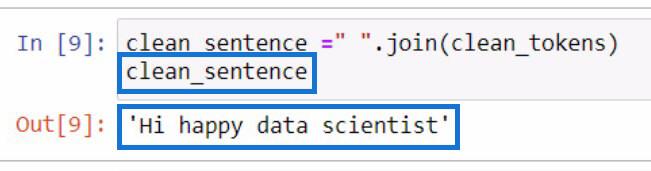

I eksemplet ovenfor oprettede vi en variabel ved navn clean_setence for at holde vores rene tokens, som vil blive kombineret til en sætning. Du kan også bemærke, at vi tilføjede et mellemrum omgivet af dobbelte anførselstegn og .join -funktionen. Inde i parametrene inkluderede vi clean_tokens- variablen.

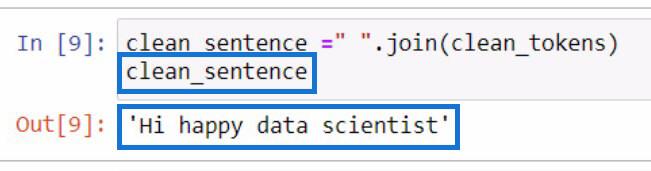

Dette vil være outputtet, hvis vi initialiserer clean_setence- variablen.

Det er bemærkelsesværdigt, at sætningen ikke ser rigtig ud, fordi vi fjernede artiklerne og tegnsætningerne tidligere.

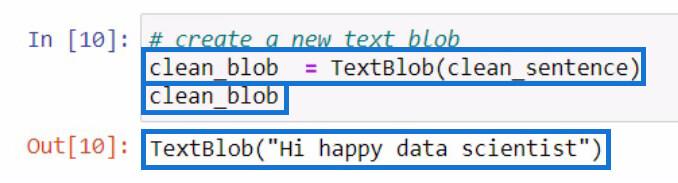

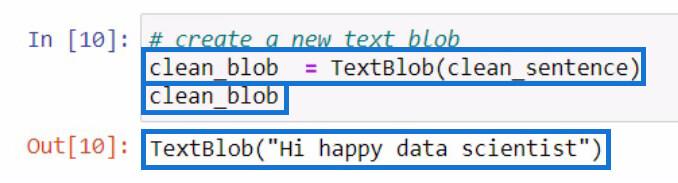

Efter at have oprettet clean_setence , lad os prøve at oprette en ny tekstblob , der indeholder clean_setence , som vi lige har oprettet. Så gemmer vi det i en ny variabel clean_blob .

Dissekere en tekstblob til dele af tale ved hjælp af .tags-funktionen

Fra denne analyseklat kan vi bruge stykkerne af denne klat til at tjekke for dele af tale eller foretage endnu flere ændringer. Lad os prøve at tjekke orddelene i hvert ord i vores nye tekstblob .

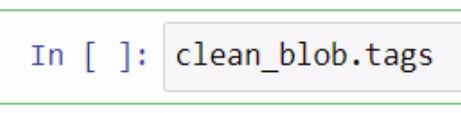

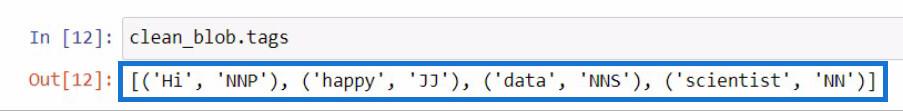

For at kontrollere dele af tale i en tekstblob, skal du bruge .tags- funktionen. Jeg gjorde dette ved at bruge vores clean_blob- variabel, og derefter tilføjede jeg .tags- funktionen lige efter.

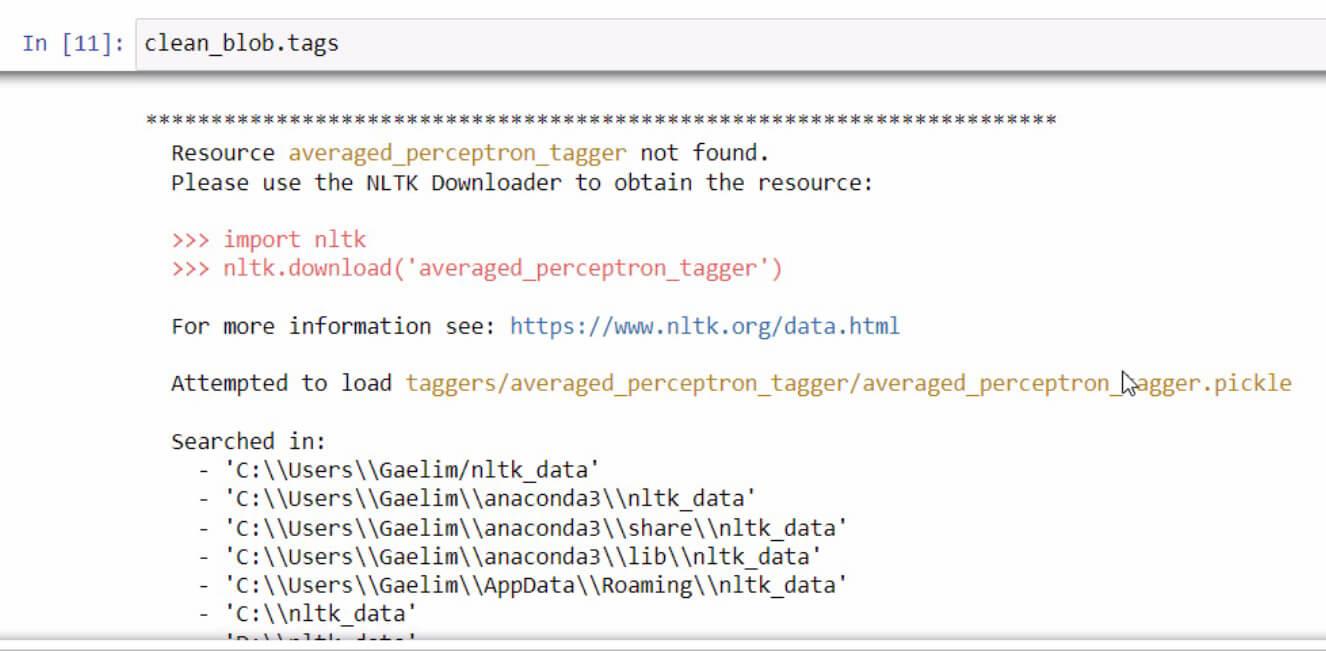

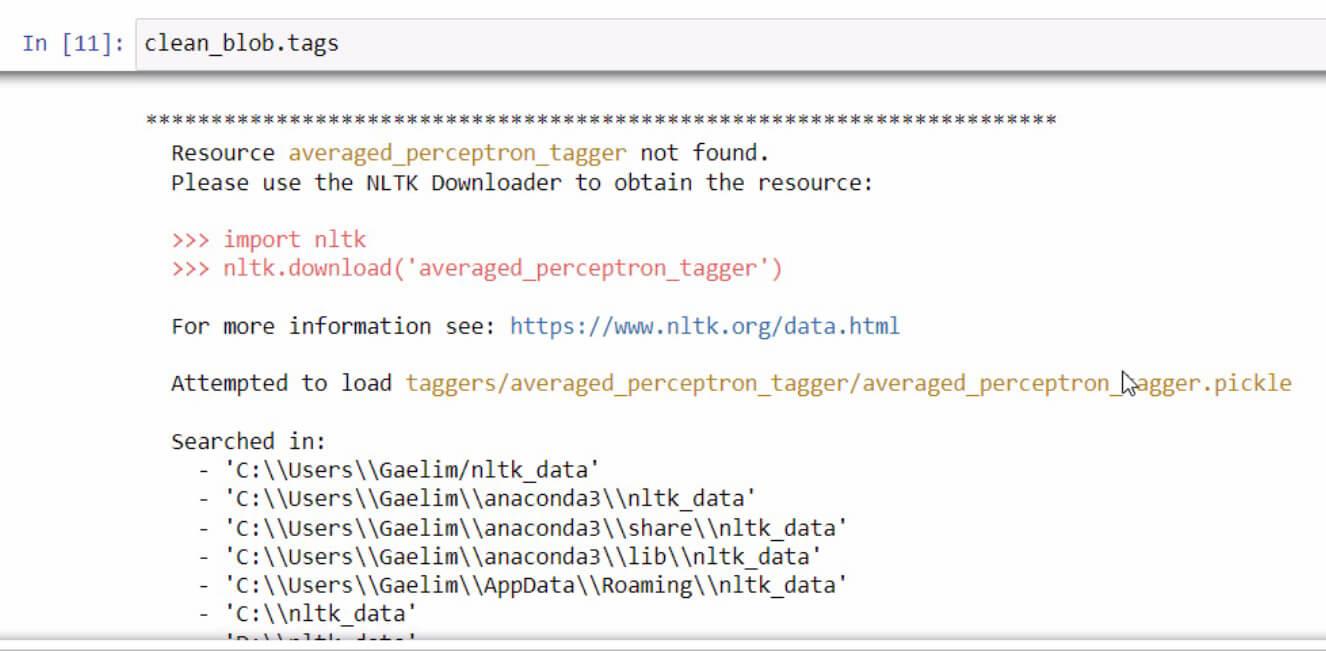

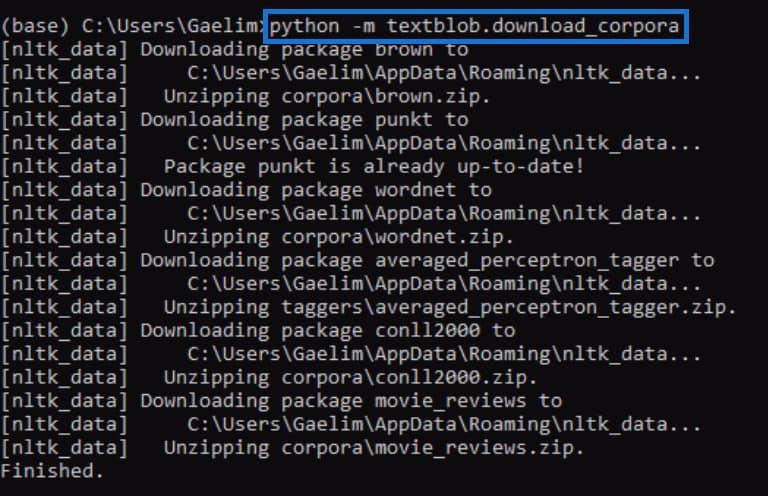

Hvis du nogensinde modtager en fejlmeddelelse ved initialisering af .tags- funktionen, skal du bare læse og følge trinene for at rette fejlen. I dette tilfælde ser det sådan ud.

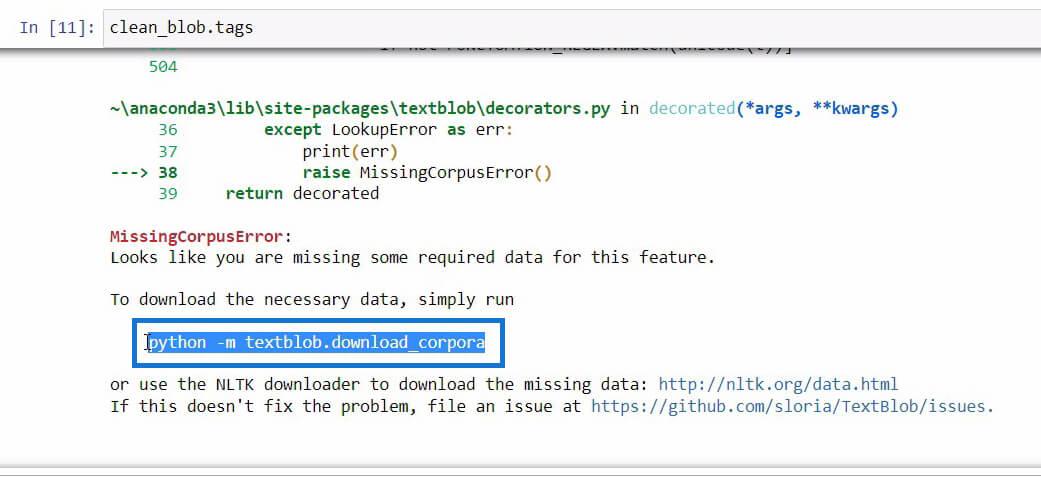

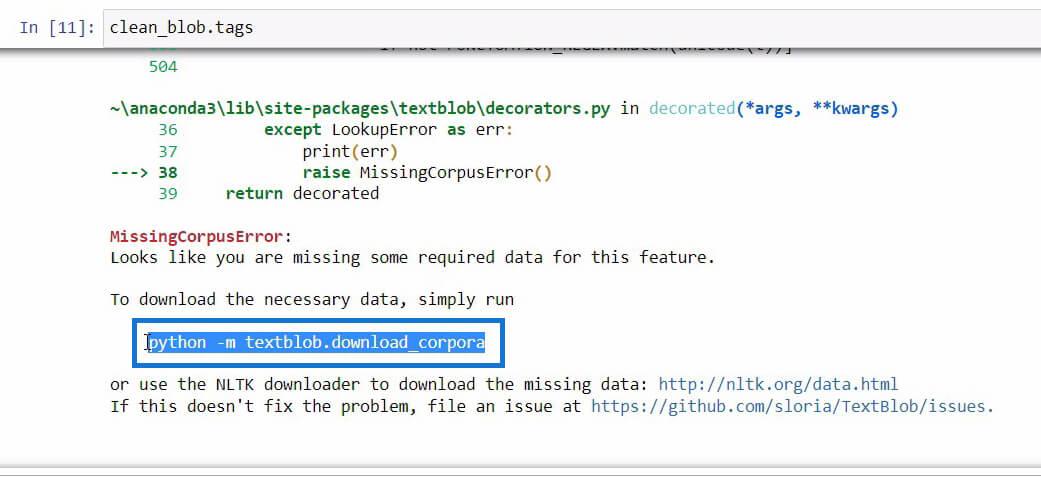

Hvis du ruller ned i slutningen af denne fejlmeddelelse, vil du se de nødvendige data, du har brug for til den funktion, du prøver at bruge.

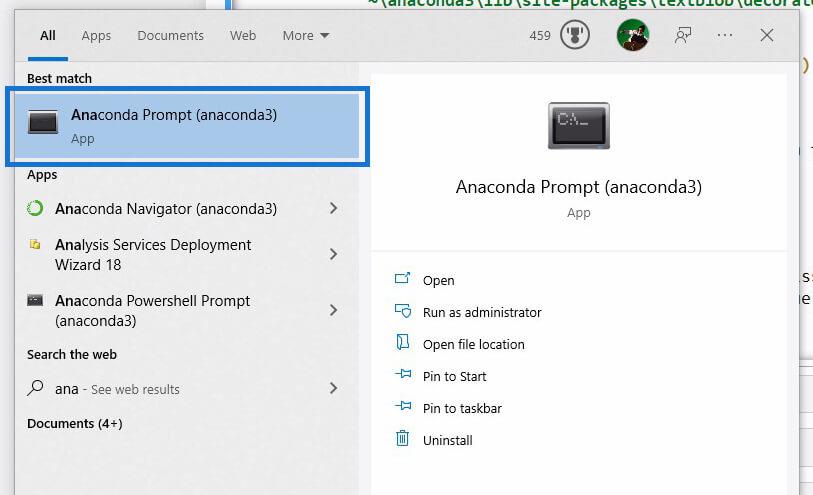

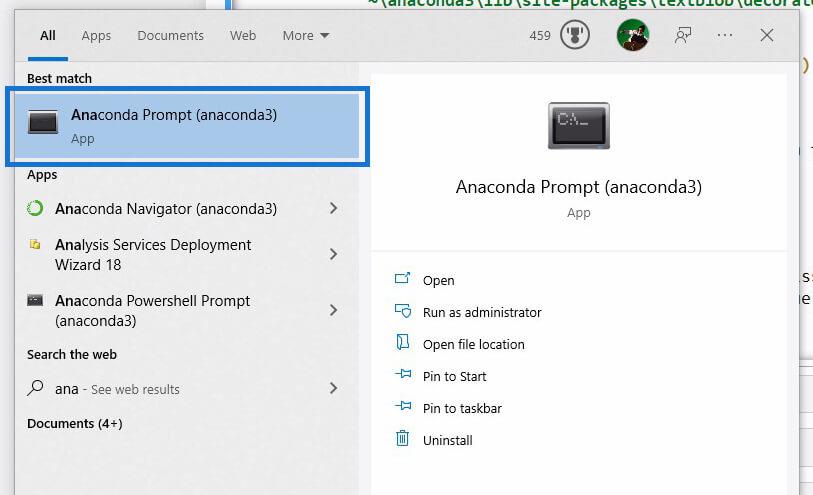

Når vi har fundet koden, som vi skal initialisere for at downloade de nødvendige data, skal du bare kopiere koden og derefter åbne ved hjælp af Windows Search .

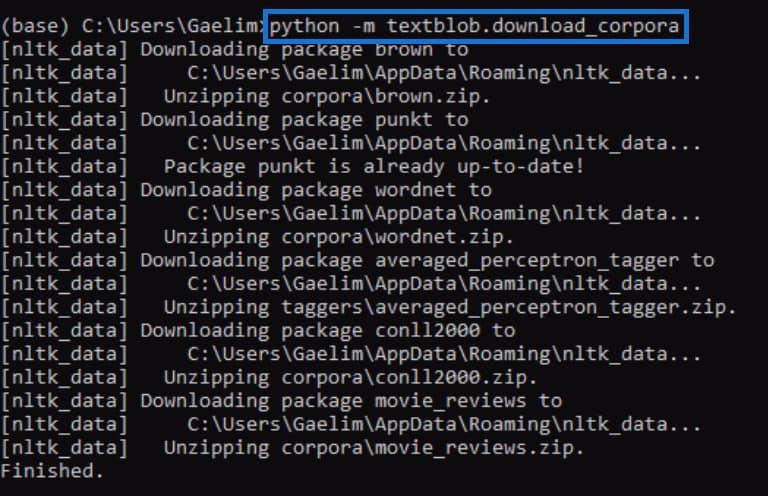

Ved hjælp af Anaconda-prompt vil vi forsøge at rette fejlen, som vi modtog ved initialisering af .tags- funktionen. Vi indsætter nu koden, som vi kopierede fra fejlmeddelelsen tidligere, og kører den ved at trykke på Enter .

Når det er færdigt, kan du prøve at køre .tags- funktionen igen og se, om det virker.

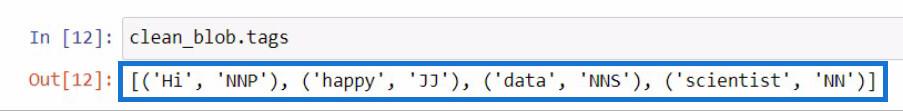

Når vi kører koden igen, kan vi se, at fejlen er rettet, og vi modtog et resultat, der indeholder hvert ord fra den nye tekstblob sammen med tags eller dele af tale.

Hvis du ikke aner, hvad disse tags betyder, kan du blot gå til textblob-webstedet for at tjekke, hvad disse tags repræsenterer.

Brug af ngrams-funktionen til tekstanalyse i Python

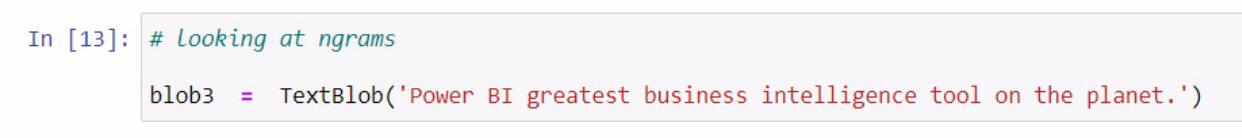

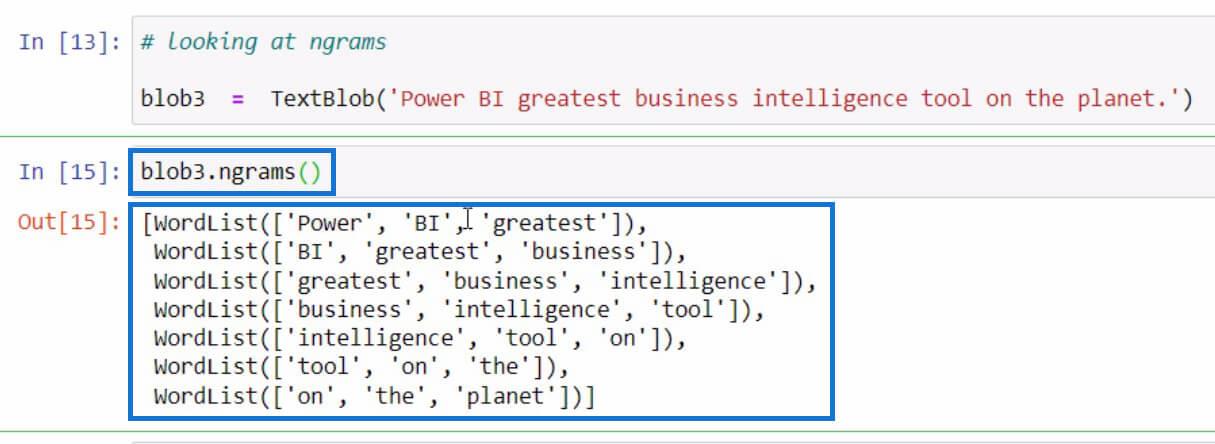

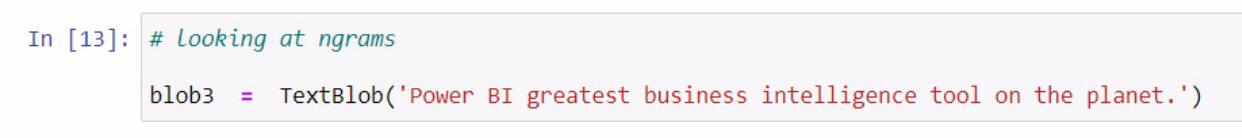

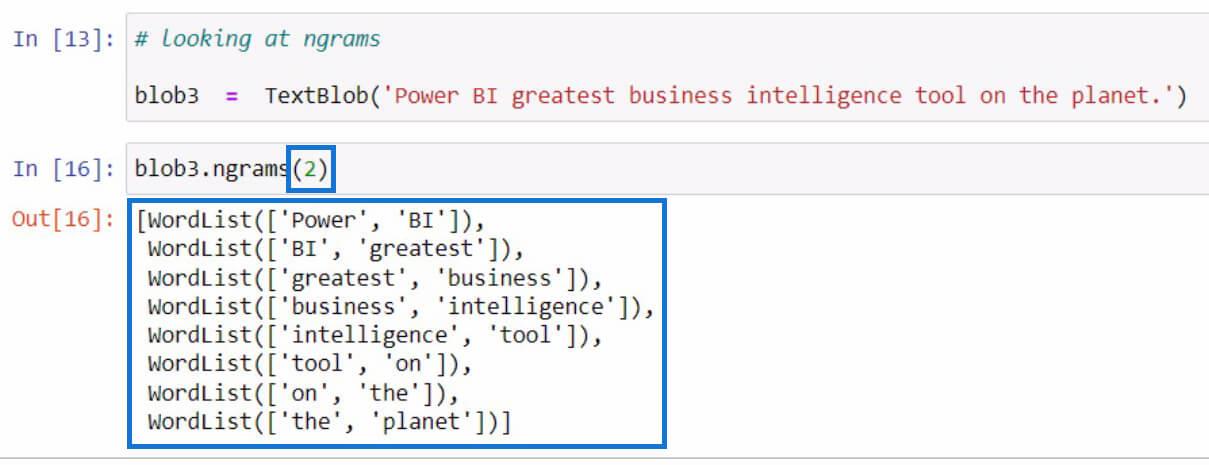

Lad os gå til et andet eksempel, som handler om at få ngrammerne . Funktionen ngrams bruges til at lede efter ord, der ofte ses sammen i en sætning eller et dokument. Lad os som et eksempel starte med at oprette en ny tekstblob og gemme den i variablen blob3 .

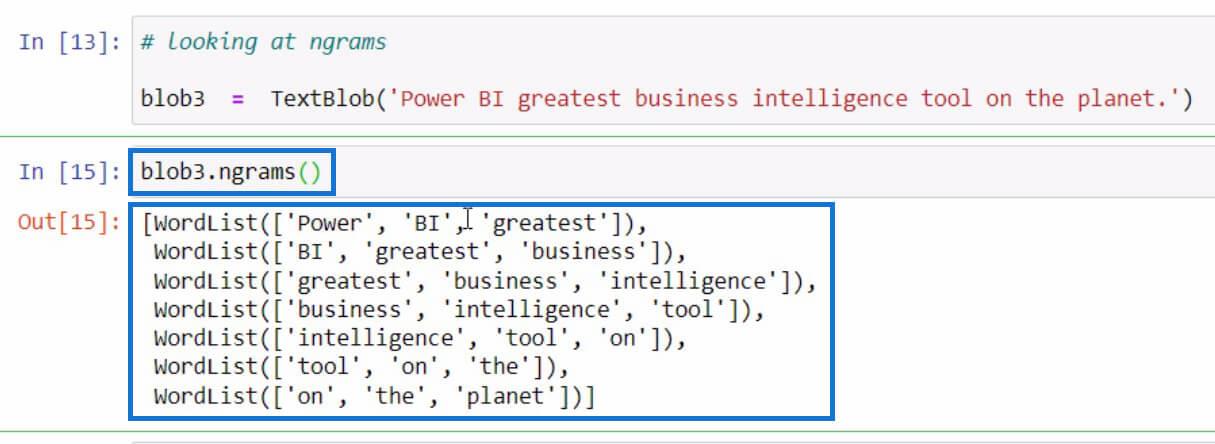

Lad os derefter bruge ngrams- funktionen i blob3- variablen til at kontrollere nogle kombinationer af ord.

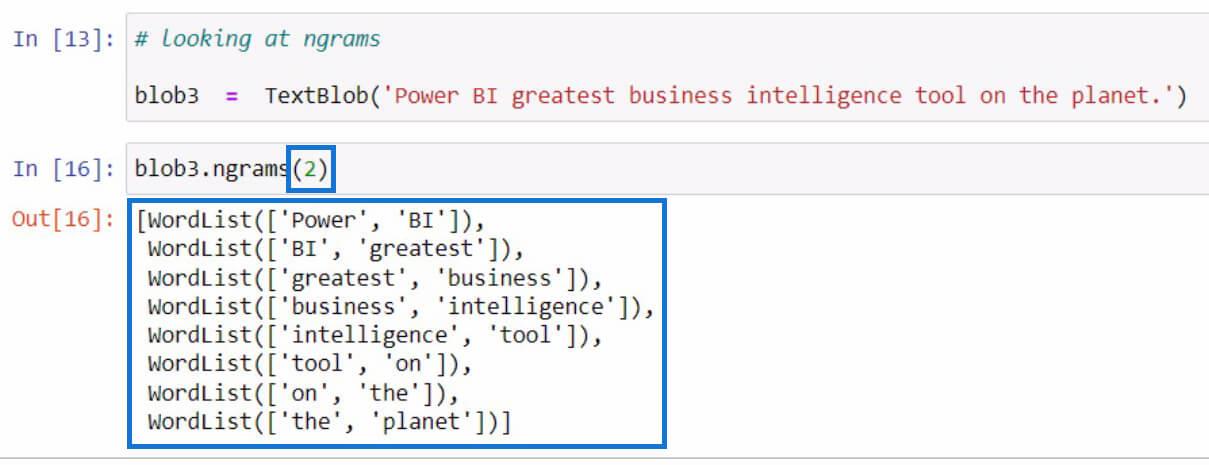

Som standard, hvis du ikke har angivet en værdi i parametrene, vil den vise trigrammer eller 3-ordskombinationer. Men hvis vi vil se 2-ordskombinationer fra sætningen, kan vi sætte 2 i parametrene som i eksemplet nedenfor.

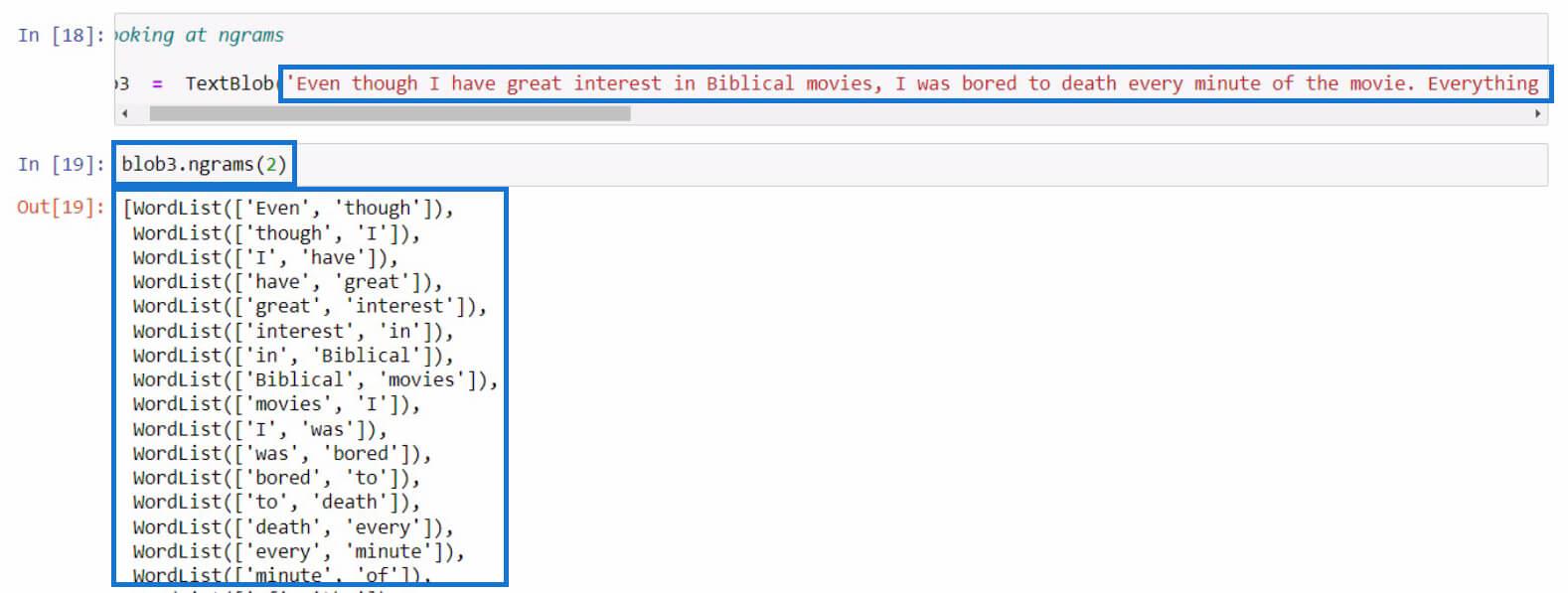

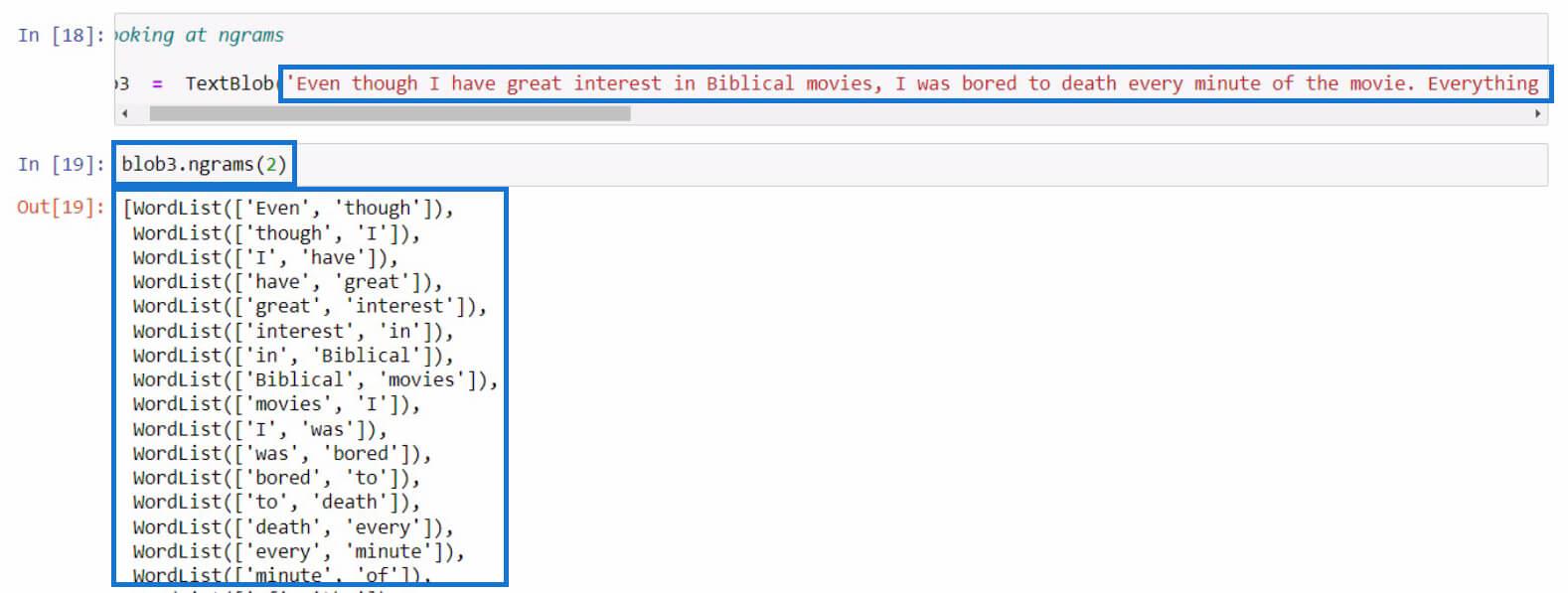

Lad os prøve det med en længere sætning denne gang. I dette eksempel har jeg lige kopieret en længere tekst fra en filmanmeldelse. Du kan bruge enhver sætning, du vil, til denne del.

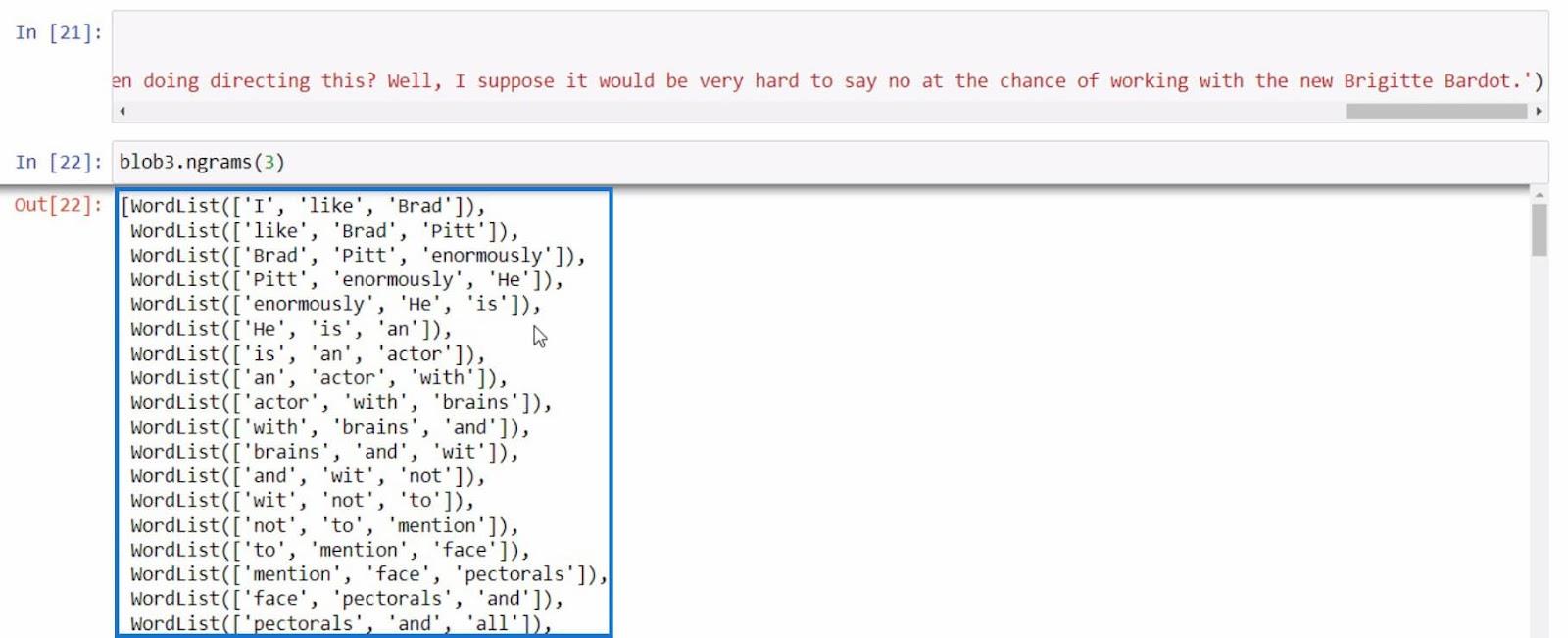

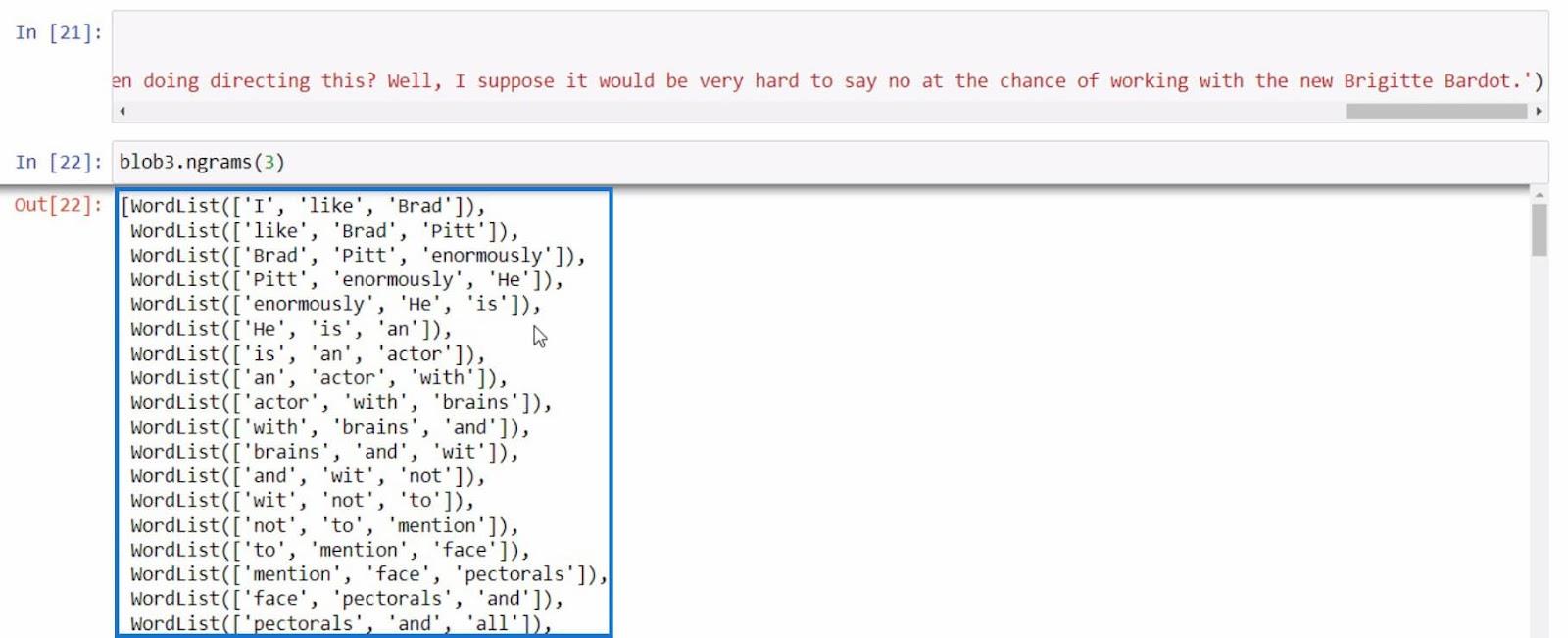

Som et sidste eksempel, lad os prøve at bruge ngrams endnu en gang med en mere informativ sætning.

Med alle disse eksempler kan vi udføre mere tekst baseret på de resultater, vi får med ngrams -funktionen.

Konklusion

For at opsummere har du lært om de forskellige funktioner, som du kan bruge til at udføre tekstanalyse i Python.

Disse er .tokenize-funktionen til at adskille ord i en sætning, .join-funktionen til at kombinere tokeniserede ord, .tags-funktionen til at kontrollere ords orddele og ngrams-funktionen til at se kombinationen af ord.

Derudover har du lært, hvordan du løser fejl som det, vi gjorde i .tags -funktionen ved hjælp af Anaconda-prompt . Du har også lært, hvordan du importerer, opretter en tekstblob og bruger dette bibliotek til at udføre tekstanalyse i .

Alt det bedste,

Gaellim