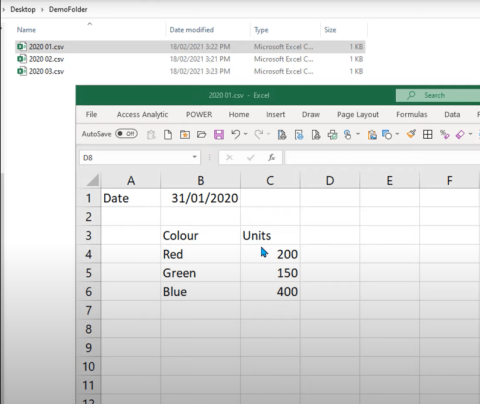

Змініть формати дати за допомогою редактора Power Query

У цьому посібнику ви дізнаєтеся, як перетворити текст у формат дати за допомогою редактора Power Query в LuckyTemplates.

У цьому блозі ми збираємося обговорити аналіз тексту в Python для створення сконструйованих даних із текстового вмісту. Це допоможе вам аналізувати великі обсяги даних і витрачати менше часу на роботу над певними завданнями. Ви також отримаєте знання про textblob , які стосуються завдань обробки природної мови.

Аналіз тексту – це процес аналізу текстів за допомогою кодів для автоматизованих процесів створення та групування текстових даних.

Перш ніж ми продовжимо, можливо, вам доведеться встановити бібліотеку, яку ми будемо використовувати в цьому посібнику.

Зміст

Реалізація аналізу тексту в Python

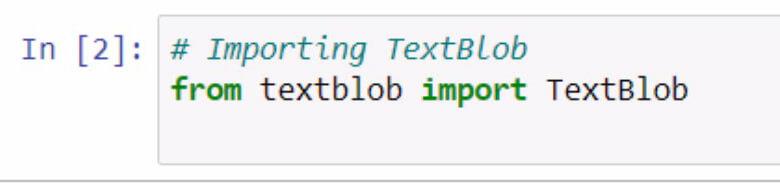

Почнемо з імпорту textblob . Не забувайте документувати те, що ви робите, використовуючи коментарі.

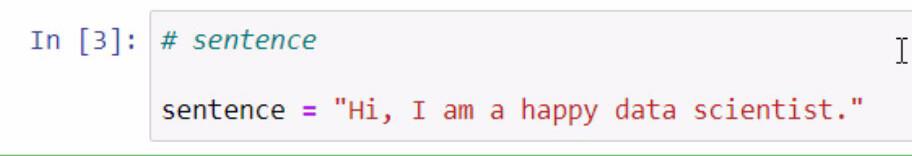

Запустивши код вище, ми тепер маємо доступ до бібліотеки текстових блоків . Наступним кроком, який ми збираємося зробити, є створення речення, яке ми будемо використовувати для наших прикладів. Ми збираємося зробити це, зберігаючи речення в змінній під назвою sentence .

Не забудьте взяти речення, яке ви хочете додати, у подвійні лапки.

Textblob — це чудова бібліотека, де ми можемо створити blob і використовувати деякі його функції для аналізу тексту в .

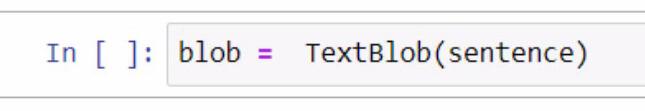

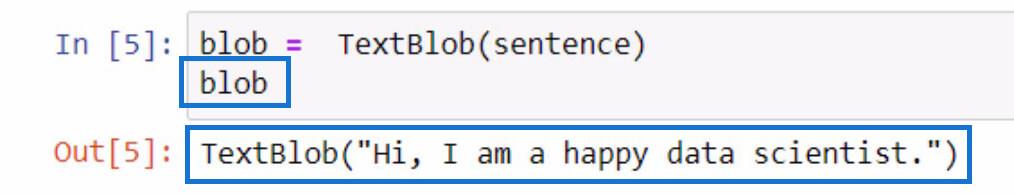

Створюючи blob, ми починаємо зі створення змінної та називаємо її blob . До цієї змінної нам потрібно додати TextBlob , який є бібліотекою, яку ми використовуємо.

У дужках ми використаємо змінну речення , яка містить речення, яке ми створили раніше. Зверніть увагу, що ви можете вручну ввести саме речення в дужках для цієї частини.

Щоб перевірити, що робить ця змінна blob , ви можете просто ініціалізувати її, ввівши назву змінної та натиснувши клавіші Shift + Enter. Результат має бути подібним до прикладу нижче.

Як ви можете бачити з результату, речення, яке ми зберегли в змінній пропозиції , тепер міститься в TextBlob .

Токенізація текстових даних у Python

Якщо ви хочете видалити деякі слова в реченні, ми можемо розділити кожне з цих слів на окремі частини в списку. З цим поданим реченням ми збираємося зробити їх лексифікованими або відокремити кожне слово та додати його до списку.

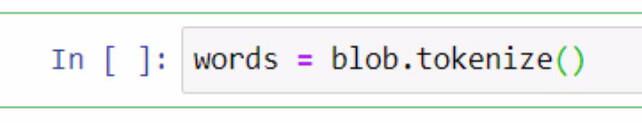

Для цього ми використаємо змінну blob і функцію tokenize . Потім ми збережемо його в змінній з назвою words .

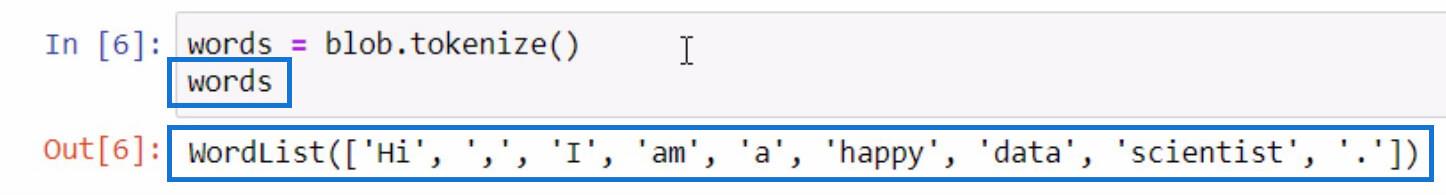

Давайте ініціалізуємо змінну words так само, як ми робили під час ініціалізації змінної blob , щоб побачити, що міститься в списку маркерів .

Як бачите, кожне слово і навіть знаки пунктуації тепер розділені у списку. Ось як працює функція tokenize .

Тепер, коли у нас є список слів, ми можемо виконувати іншу функцію з нього. Давайте створимо ще один список слів, які ми не хочемо включати в наш список, як-от знаки пунктуації та артиклі. Щоб виконати цей крок, перегляньте знімок екрана н��жче.

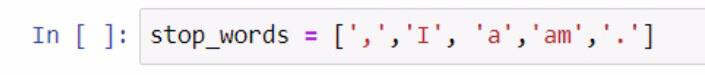

Під час створення списку стоп-слів ми використовували дужки, щоб укласти список стоп-слів. Потім кожне стоп-слово береться в одинарні лапки та відокремлюється комою. Ми зберегли список у змінній stop_words .

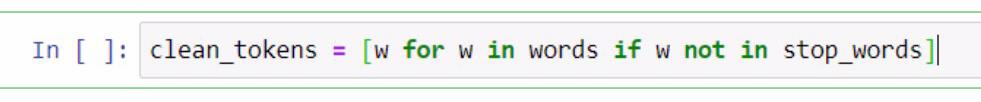

Звідси ми виконаємо розуміння списку , щоб видалити слова, необхідні для аналізу тексту мовою . Це включає очищення речень, токенізацію та порівняння різних списків. Зараз ми порівняємо ці два списки та створимо новий список clean_tokens .

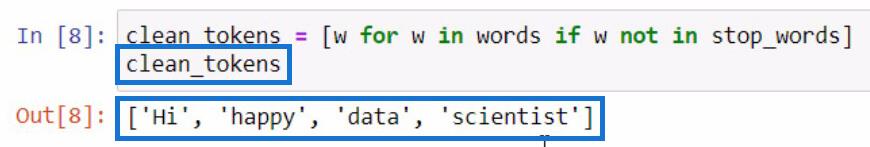

У наведеному вище коді ми використали заповнювач w для представлення елемента . Те, що ми намагаємося зробити в цій частині, це отримати елемент у змінній words, якщо елемент не існує в змінній stop_words . Якщо ми збираємося ініціалізувати clean_tokens , це буде результат.

У цьому процесі ми можемо очистити наші маркери , запустивши процес видалення непотрібних маркерів, таких як знаки пунктуації та артиклі. Через це в нашому списку залишилися лише основні слова.

Об’єднання токенів для створення речення в Python

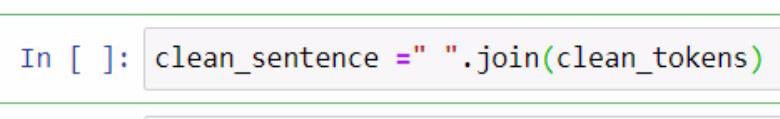

Тепер, коли ми відокремили чисті лексеми , давайте спробуємо помістити їх у одне речення. Для цього ми повинні використовувати функцію .join . Перегляньте приклад нижче для довідки.

У наведеному вище прикладі ми створили змінну під назвою clean_sentence для зберігання чистих токенів, які буде об’єднано в речення. Ви також можете помітити, що ми додали пробіл у подвійних лапках і функцію .join . Всередині параметрів ми включили змінну clean_tokens .

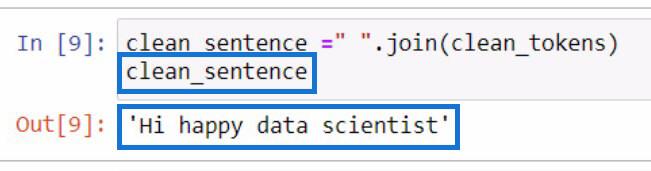

Це буде результат, якщо ми ініціалізуємо змінну clean_sentence .

Помітно, що речення виглядає неправильно, тому що ми видалили артиклі та розділові знаки раніше.

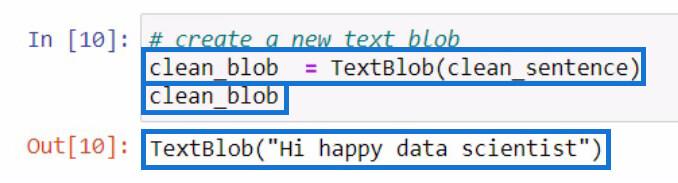

Після створення clean_sentence давайте спробуємо створити новий текстовий блок , який містить clean_sentence , який ми щойно створили. Потім ми збережемо його в новій змінній clean_blob .

Розбирання текстового блоку для частин мови за допомогою функції .tags

З цієї краплі аналізу ми можемо використовувати частини цієї краплі, щоб перевірити наявність частин мови або внести ще більше змін. Давайте спробуємо перевірити частини мови кожного слова в нашому новому текстовому блоку .

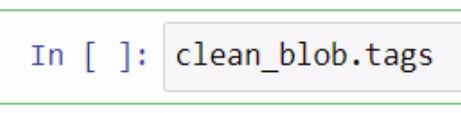

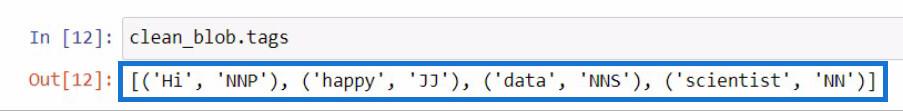

Щоб перевірити частини мови в текстовому блоку, вам слід скористатися функцією .tags . Я зробив це, використовуючи нашу змінну clean_blob , а потім одразу додав функцію .tags .

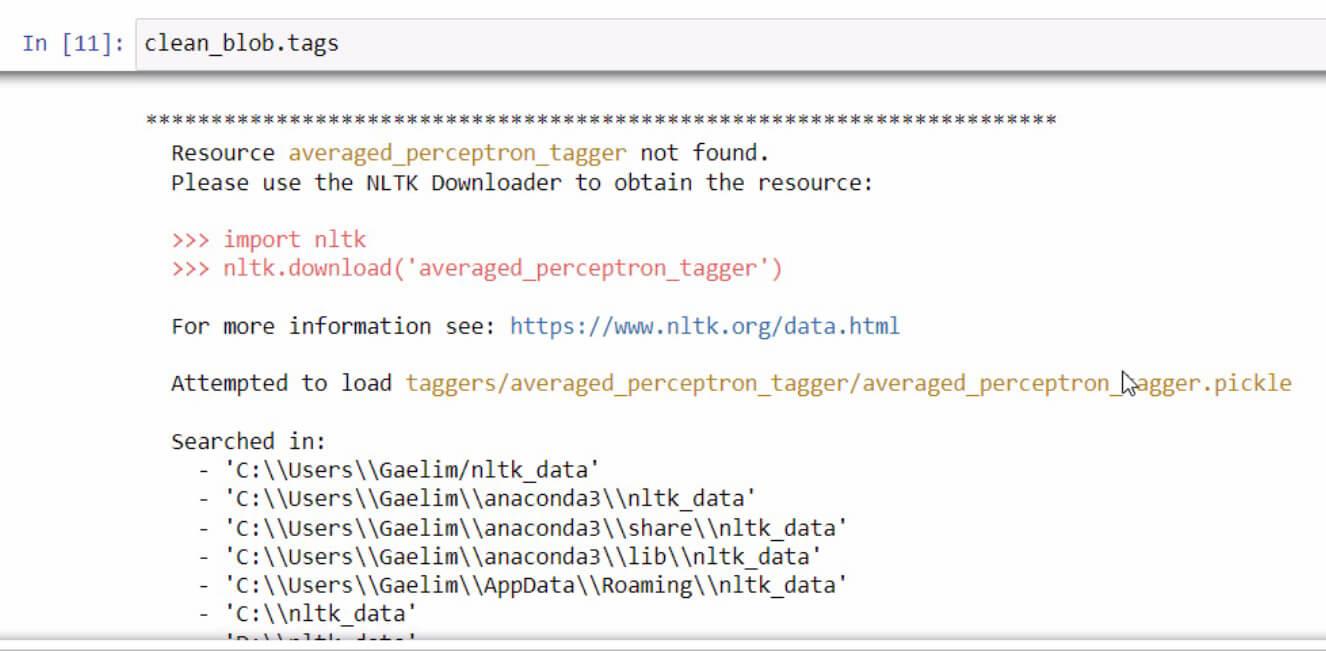

Якщо під час ініціалізації функції .tags ви отримаєте повідомлення про помилку , просто прочитайте та виконайте кроки, щоб виправити помилку. В даному випадку це виглядає так.

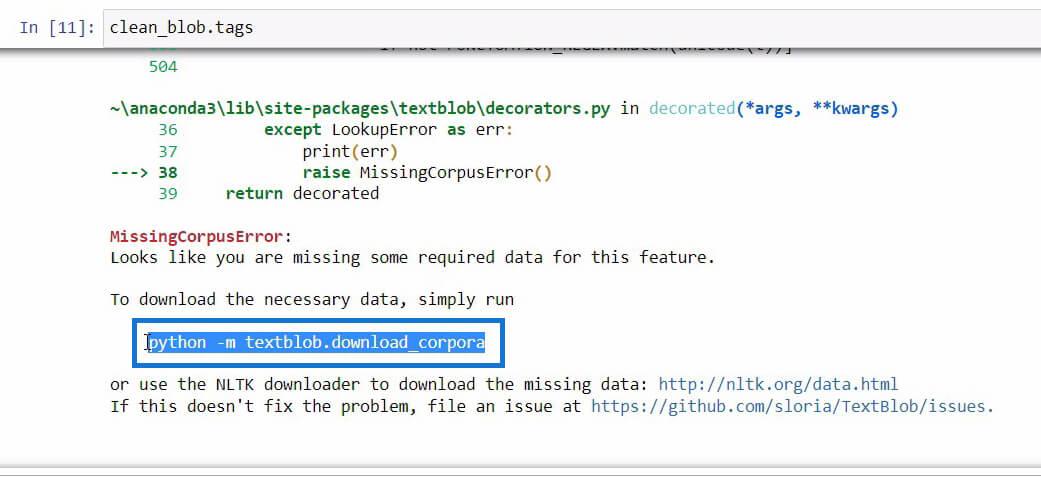

Якщо прокрутити вниз до кінця цього повідомлення про помилку, ви побачите необхідні дані, необхідні для функції, яку ви намагаєтеся використати.

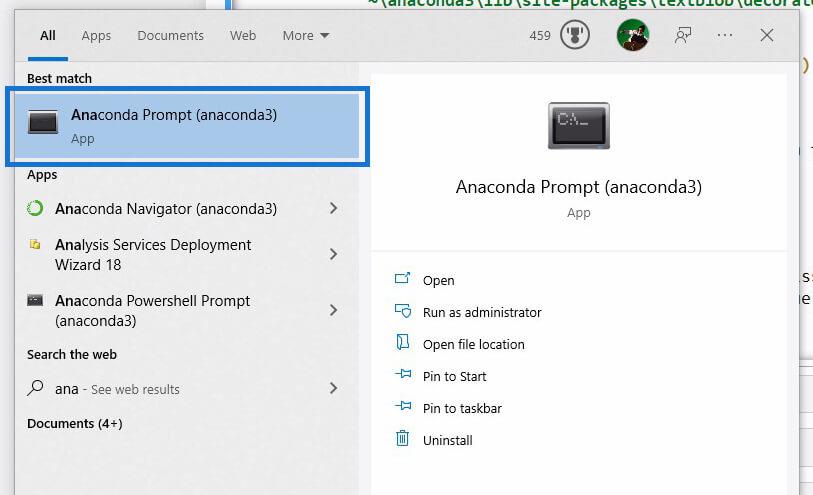

Коли ми знайдемо код, який потрібно ініціалізувати, щоб завантажити необхідні дані, просто скопіюйте код і відкрийте його за допомогою пошуку Windows .

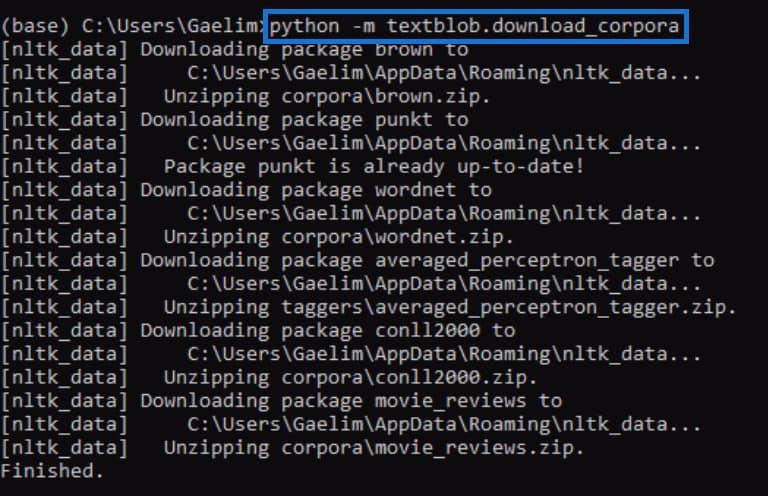

Використовуючи Anaconda Prompt , ми спробуємо виправити помилку, яку ми отримали під час ініціалізації функції .tags . Тепер ми вставимо код, який ми скопіювали з повідомлення про помилку раніше, і запустимо його, натиснувши Enter .

Після завершення спробуйте знову запустити функцію .tags і перевірте, чи вона працює.

Після повторного запуску коду ми бачимо, що помилку виправлено, і ми отримали результат, який містить кожне слово з нового текстового блоку разом із тегами чи частинами мови.

Якщо ви не знаєте, що означають ці теги , ви можете просто перейти на веб-сайт textblob , щоб перевірити, що представляють ці теги.

Використання функції ngrams для аналізу тексту в Python

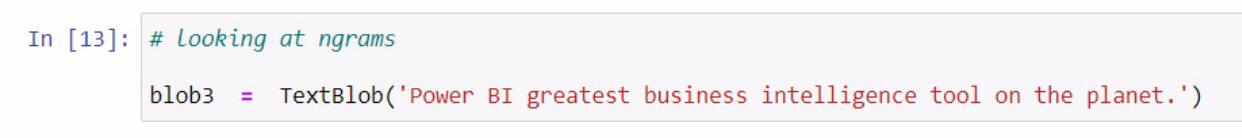

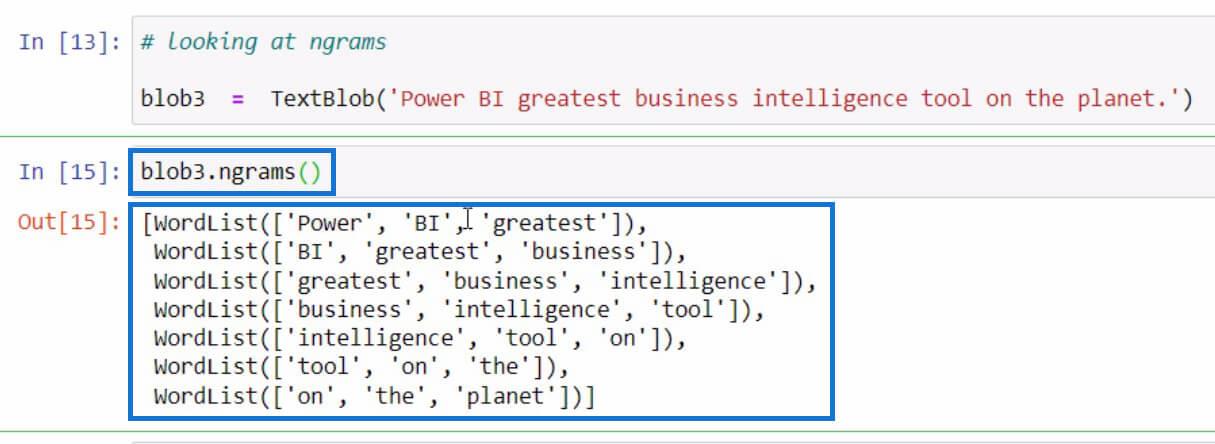

Давайте перейдемо до іншого прикладу, який стосується отримання ngrams . Функція ngrams використовується для пошуку слів, які часто зустрічаються разом у реченні чи документі. Як приклад, давайте почнемо зі створення нового текстового блоку та збережемо його в змінній blob3 .

Після цього скористаємося функцією ngrams у змінній blob3 , щоб перевірити деякі комбінації слів.

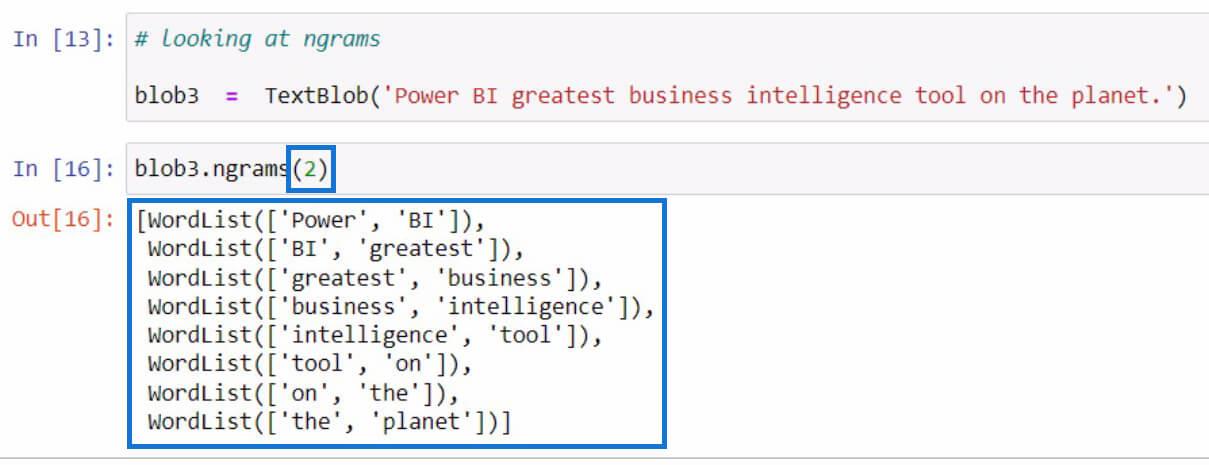

За замовчуванням, якщо ви не вказали значення в параметрах, відображатимуться триграми або комбінації з трьох слів. Але якщо ми хочемо бачити комбінації з двох слів у реченні, ми можемо встановити 2 у параметрах, як у прикладі нижче.

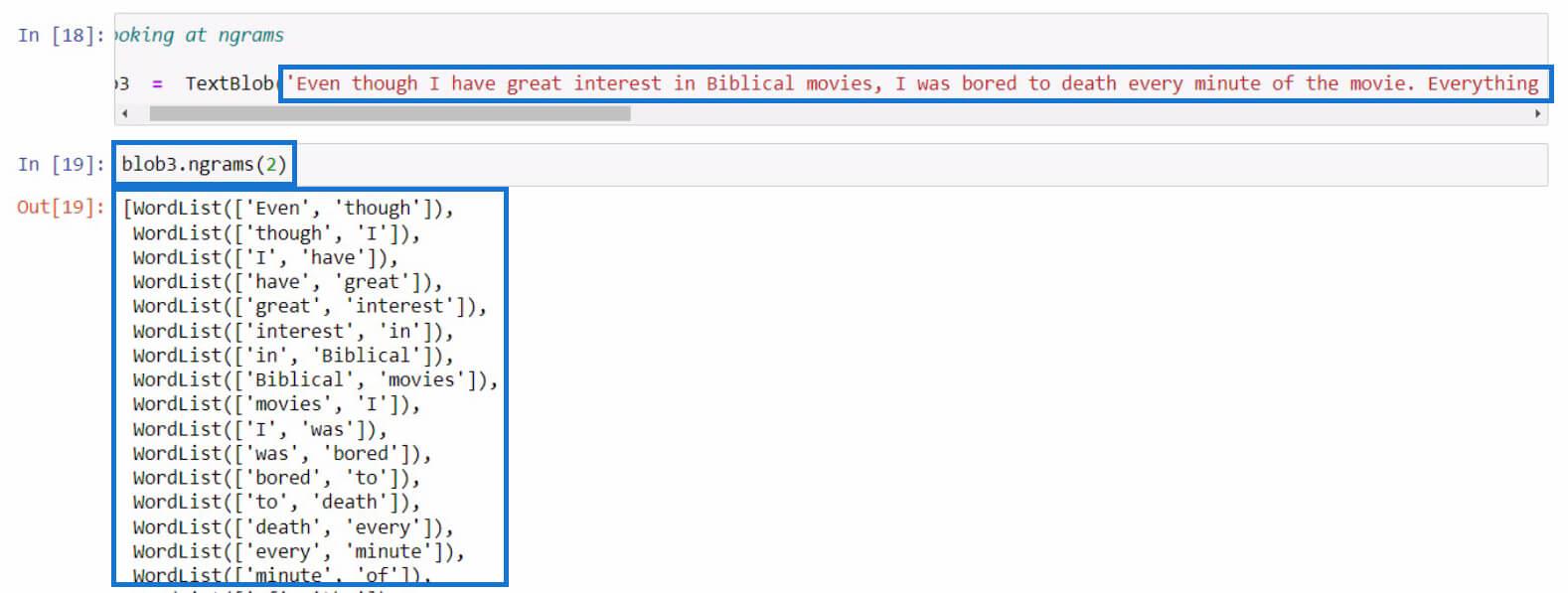

Спробуймо цього разу з довшим реченням. У цьому прикладі я просто скопіював довший текст із огляду фільму. Ви можете використовувати будь-яке речення для цієї частини.

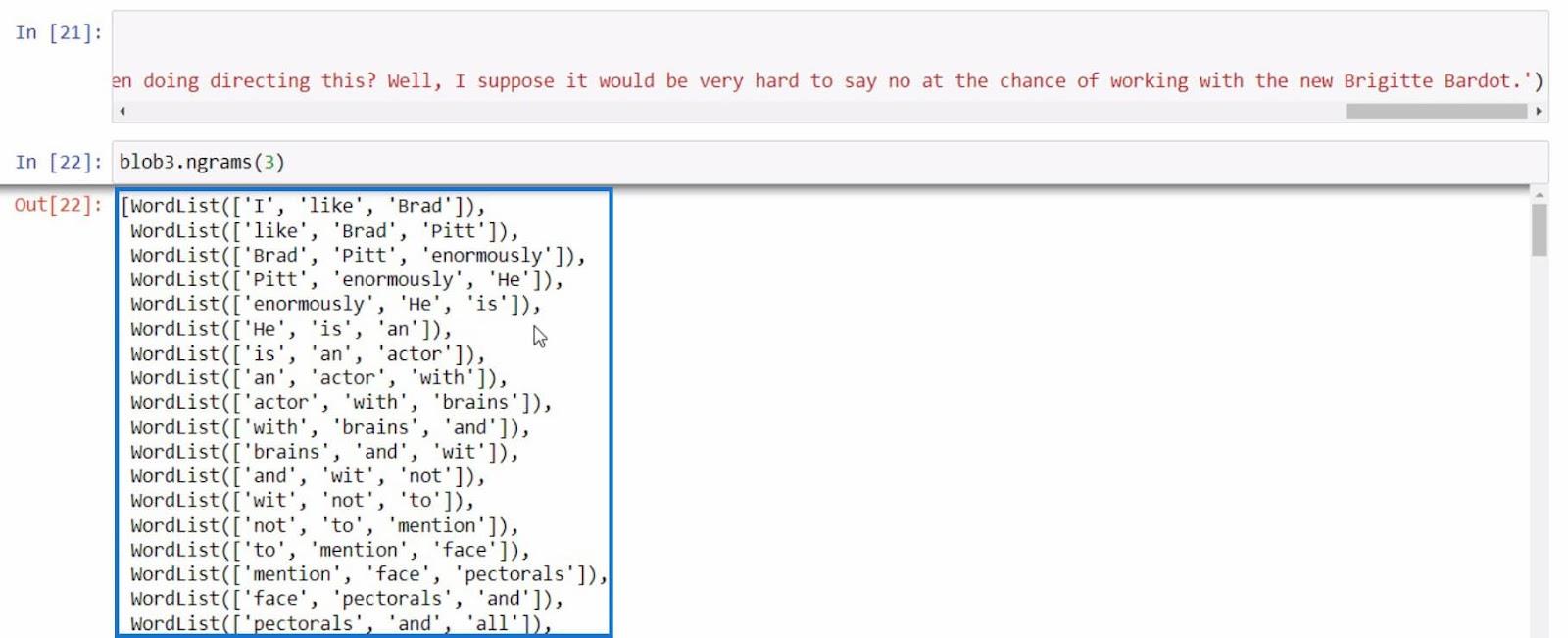

Як останній приклад, давайте спробуємо використати ngrams ще раз із більш інформативним реченням.

З усіма цими прикладами ми можемо створити більше тексту на основі результатів, які ми отримуємо за допомогою функції ngrams .

Висновок

Підсумовуючи, ви дізналися про різні функції, які можна використовувати для аналізу тексту в Python.

Це функція .tokenize для розділення слів у реченні, функція .join для об’єднання токенізованих слів, функція .tags для перевірки частин мови слів і функція ngrams для перегляду сполучення слів.

Крім того, ви дізналися, як виправляти помилки, подібні до того, що ми робили у функції .tags за допомогою Anaconda Prompt . Ви також навчилися імпортувати, створювати текстовий блок і використовувати цю бібліотеку для аналізу тексту в .

Все найкраще,

Гаеллім

У цьому посібнику ви дізнаєтеся, як перетворити текст у формат дати за допомогою редактора Power Query в LuckyTemplates.

Дізнайтеся, як об’єднати файли з кількох папок у мережі, робочому столі, OneDrive або SharePoint за допомогою Power Query.

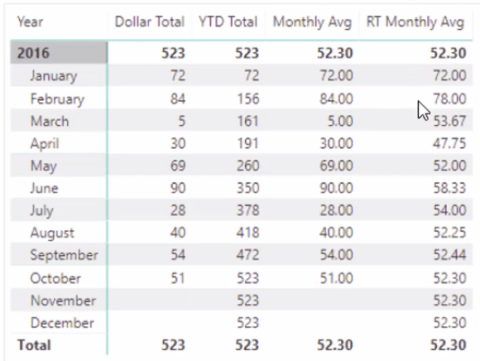

Цей підручник пояснює, як обчислити місячне ковзне середнє на базі даних з початку року за допомогою функцій AVERAGEX, TOTALYTD та FILTER у LuckyTemplates.

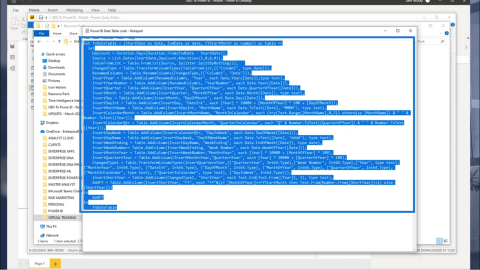

Дізнайтеся, чому важлива спеціальна таблиця дат у LuckyTemplates, і вивчіть найшвидший і найефективніший спосіб це зробити.

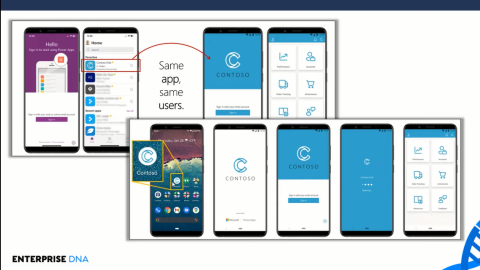

У цьому короткому посібнику розповідається про функцію мобільних звітів LuckyTemplates. Я збираюся показати вам, як ви можете ефективно створювати звіти для мобільних пристроїв.

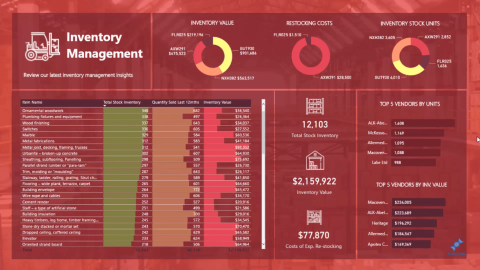

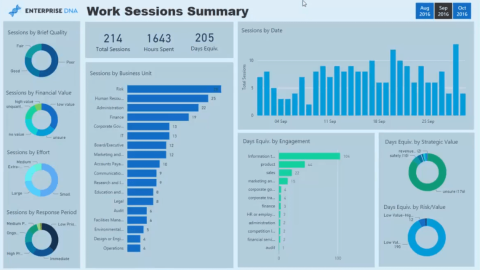

У цій презентації LuckyTemplates ми розглянемо звіти, що демонструють професійну аналітику послуг від фірми, яка має кілька контрактів і залучених клієнтів.

Ознайомтеся з основними оновленнями для Power Apps і Power Automate, а також їх перевагами та наслідками для Microsoft Power Platform.

Відкрийте для себе деякі поширені функції SQL, які ми можемо використовувати, наприклад String, Date і деякі розширені функції для обробки та маніпулювання даними.

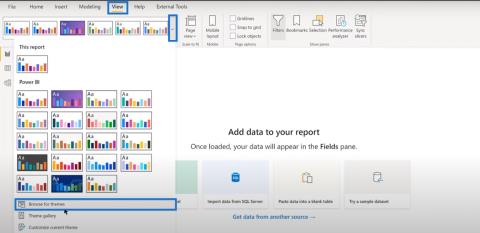

У цьому підручнику ви дізнаєтеся, як створити свій ідеальний шаблон LuckyTemplates, налаштований відповідно до ваших потреб і вподобань.

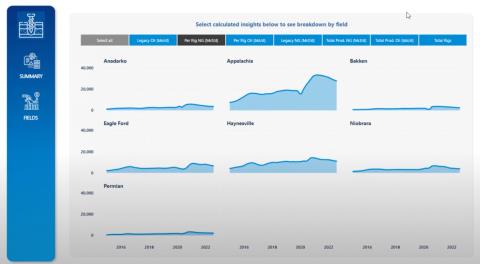

У цьому блозі ми продемонструємо, як шарувати параметри поля з малими кратними, щоб створити неймовірно корисну інформацію та візуальні ефекти.