Du kanske har läst att åtgärder som används på en Excel-instrumentpanel absolut borde stödja det ursprungliga syftet med den instrumentpanelen. Samma koncept gäller för back-end-datamodellen. Du bör endast importera data som är nödvändig för att uppfylla syftet med din instrumentpanel eller rapport.

I ett försök att ha så mycket data som möjligt till hands, tar många Excel-användare in i sina kalkylblad varje bit data de kan få tag på. Du kan upptäcka dessa personer genom de 40 megabyte filerna de skickar via e-post. Du har sett dessa kalkylblad — två flikar som innehåller något rapporterings- eller instrumentpanelsgränssnitt och sedan sex dolda flikar som innehåller tusentals rader med data (varav de flesta inte används). De bygger i huvudsak en databas i sitt kalkylblad.

Vad är det för fel med att använda så mycket data som möjligt? Tja, här är några frågor:

-

Aggregering av data i Excel ökar antalet formler. Om du tar in all rådata måste du aggregera dessa data i Excel. Detta får dig oundvikligen att exponentiellt öka antalet formler du måste använda och underhålla.

Kom ihåg att din datamodell är ett verktyg för att presentera analyser, inte att bearbeta rådata. Den data som fungerar bäst i rapporteringsmekanismer är den som redan har aggregerats och sammanfattats i användbara vyer som kan navigeras och matas till instrumentpanelens komponenter. Att importera data som redan har aggregerats så mycket som möjligt är mycket bättre.

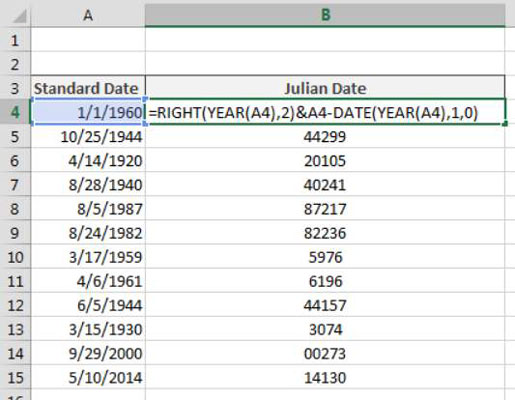

Om du till exempel behöver rapportera om intäkter per region och månad, behöver du inte importera försäljningstransaktioner till din datamodell. Använd istället en aggregerad tabell som består av region, månad och summa av intäkter.

-

Din datamodell kommer att distribueras med din instrumentpanel. Med andra ord, eftersom din instrumentpanel matas av din datamodell, måste du underhålla modellen bakom kulisserna (troligen i dolda flikar) när du distribuerar instrumentpanelen. Förutom det faktum att det gör att filstorleken blir otymplig, kan inkludering av för mycket data i din datamodell faktiskt försämra prestandan för din instrumentpanel. Varför?

När du öppnar en Excel-fil laddas hela filen in i minnet för att säkerställa snabb databearbetning och åtkomst. Nackdelen med detta beteende är att Excel kräver en hel del RAM-minne för att bearbeta även den minsta förändringen i ditt kalkylblad. Du kanske har märkt att när du försöker utföra en åtgärd på en stor, formelintensiv datauppsättning, svarar Excel långsamt, vilket ger dig en beräkningsindikator i statusfältet. Ju större din datauppsättning är, desto mindre effektiv är datakrossningen i Excel.

-

Stora datamängder kan orsaka svårigheter med skalbarhet. Föreställ dig att du arbetar i ett litet företag och att du använder månatliga transaktioner i din datamodell. Varje månad innehåller 80 000 rader med data. Allt eftersom tiden går bygger du en robust process komplett med alla formler, pivottabeller och makron du behöver för att analysera data som lagras på din välskötta flik.

Vad händer nu efter ett år? Startar du en ny flik? Hur analyserar man två datauppsättningar på två olika flikar som en enhet? Är dina formler fortfarande bra? Måste du skriva nya makron?

Det här är alla problem som kan undvikas genom att endast importera aggregerade och sammanfattade data som är användbara för det centrala syftet med dina rapporteringsbehov.