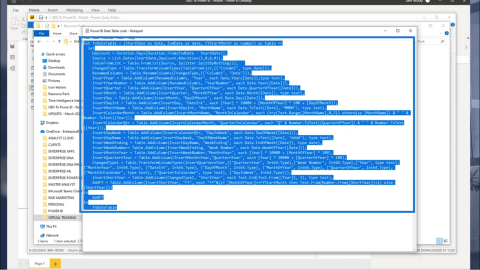

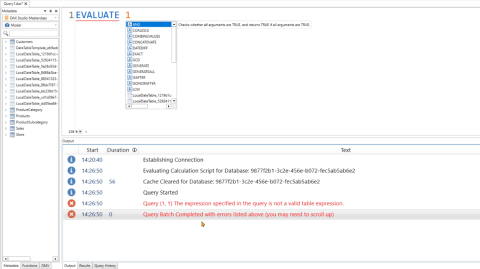

DAX Studio EVALUATE Nøkkelord: Grunnleggende eksempler

Lær å bruke DAX Studio EVALUATE nøkkelordet med grunnleggende eksempler og få en bedre forståelse av hvordan dette kan hjelpe deg med databehandling.

I denne bloggen vil vi vise deg hvordan du bruker Python for å identifisere deler av tale i tekstdata i LuckyTemplates. Vi vil dekke trinnene for bruk av Python for tekstanalyse og gi eksempler og tips for å hjelpe deg i gang med dine egne tekstanalyseprosjekter. Du kan se hele videoen av denne opplæringen nederst på denne bloggen.

Innholdsfortegnelse

Kildedata

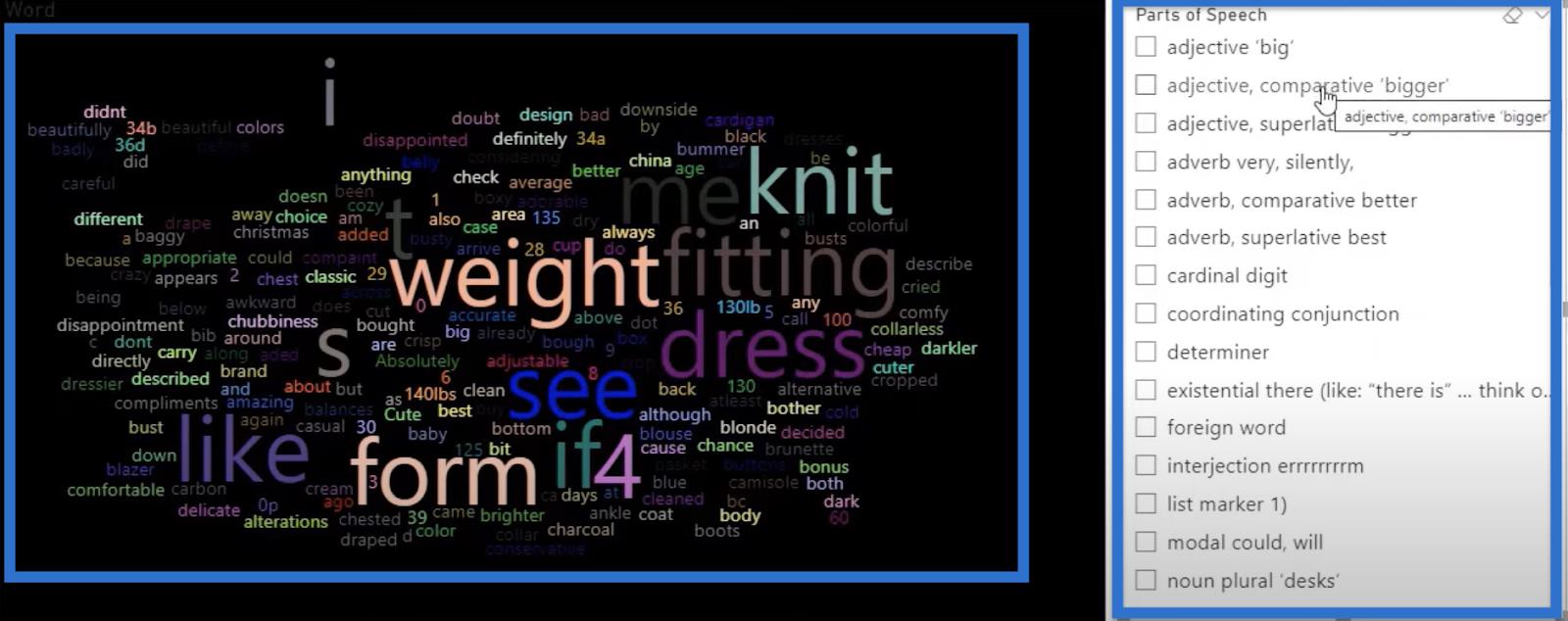

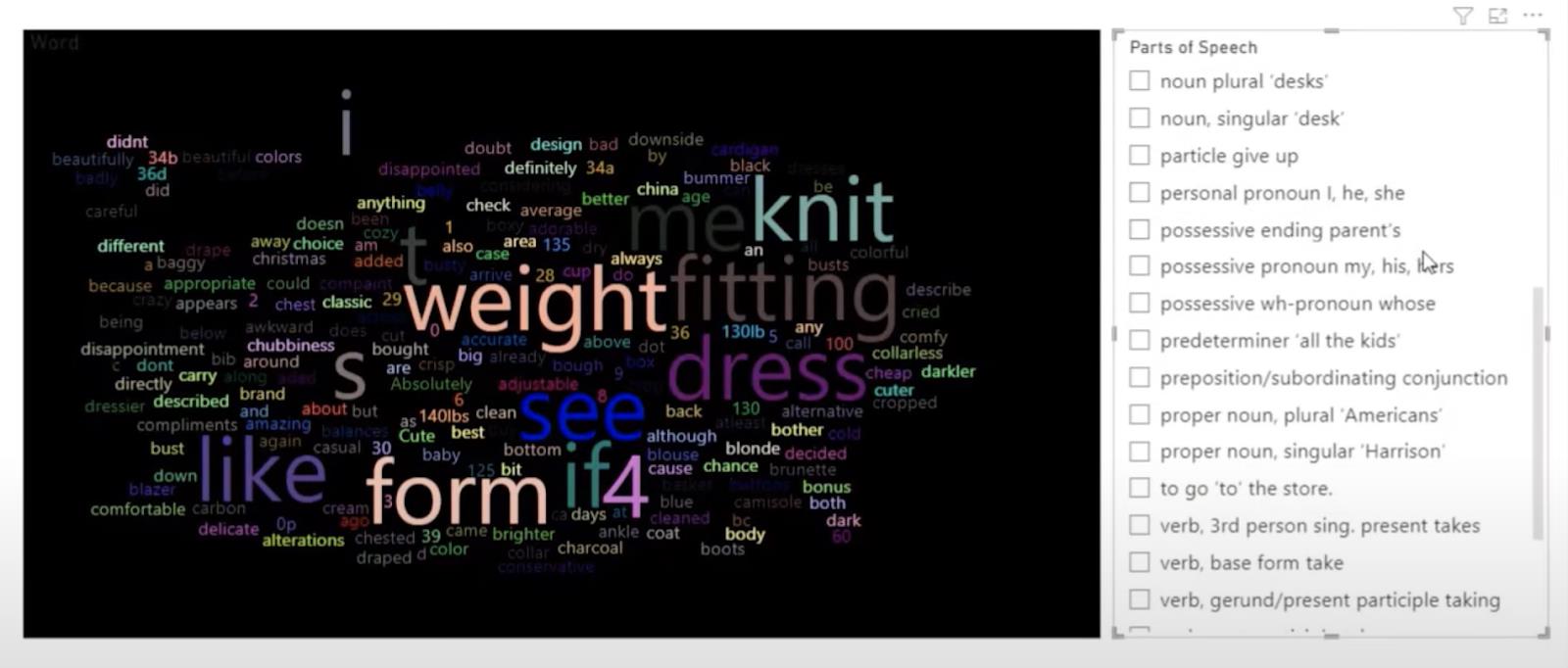

I denne opplæringen vil vi bruke en ut-av-boksen ordsky som inneholder tekstene vi skal evaluere. Dette vises på venstre side av bildet nedenfor. På høyre side har vi filtrene for å identifisere de ulike delene av talen, for eksempel adjektiver eller verb.

Vi kan filtrere ut ord som er adverb, substantiv, ulike typer substantiv eller verb, og verbbaser. Dette er veldig nyttig når du lager en markedsføringskampanje og ser etter ord i kundeanmeldelser.

La oss starte med å åpne redaktøren vår.

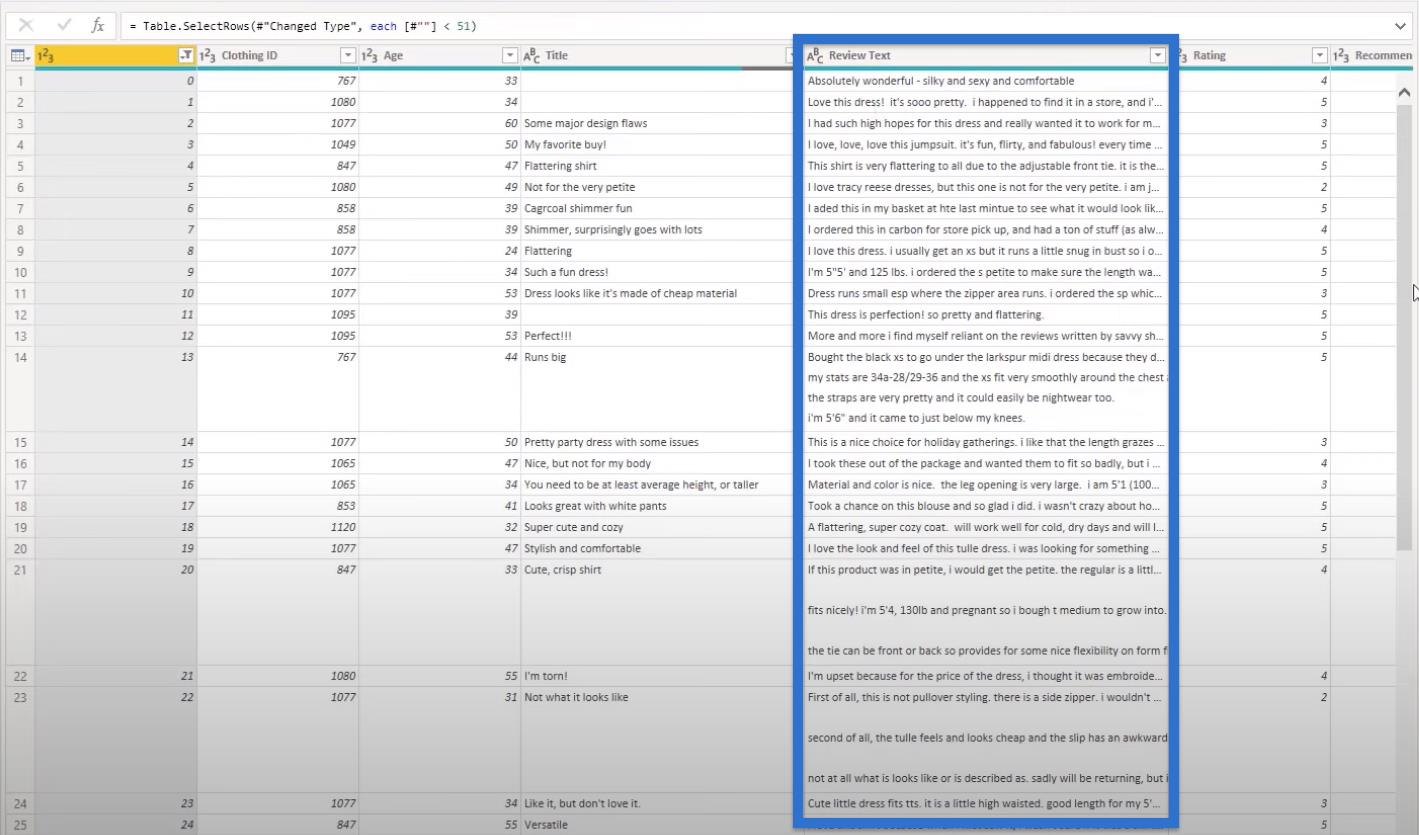

I kildedataene våre har vi kolonner for ID-er, alder, tittel og anmeldelsestekst. Vi vil fokusere på gjennomgangstekst- kolonnen, og vi vil analysere den for å gjøre tekstanalysen vår. Det er også andre kategorier som kan være nyttige i vår analyse.

Tekstanalyse ved hjelp av Python

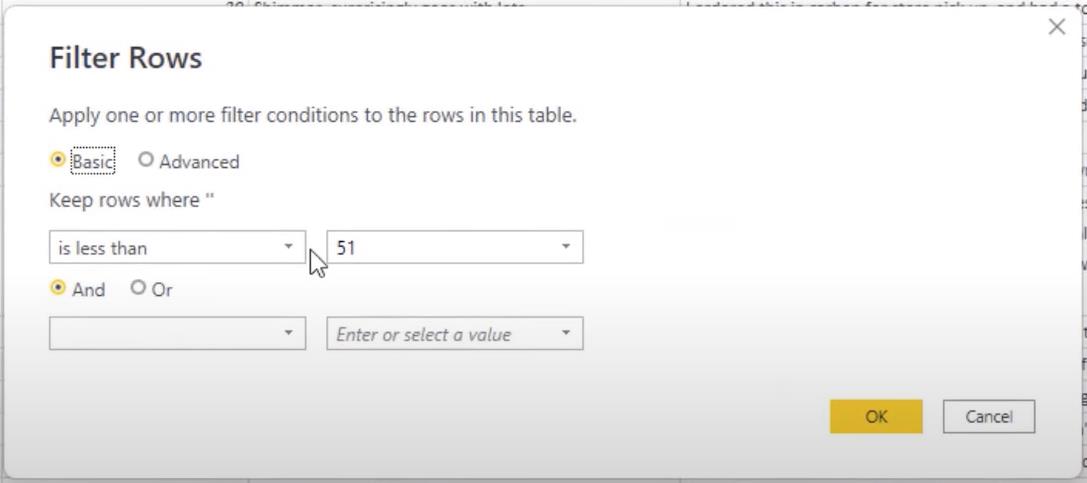

La oss starte med de vanlige dataene vi hentet inn. Det første vi skal gjøre er å filtrere radene fordi vi har mye data, og når vi gjør tekstanalyse tar det tid.

For å filtrere dataene våre, ta de første 50 radene for å gjøre tekstanalysen litt raskere.

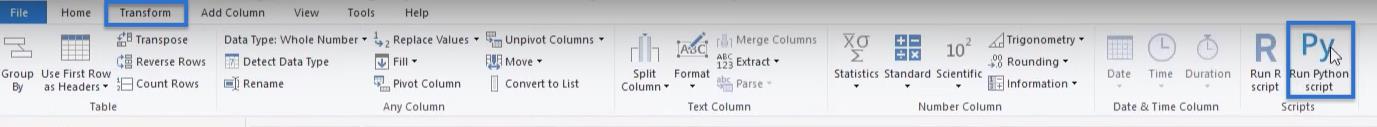

Når du er filtrert ut, gå til Transform and Run script. Vi vil kode alt her inne fordi det ikke er mye kode.

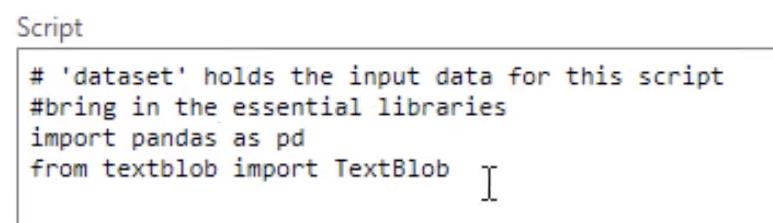

Importerer pakkene

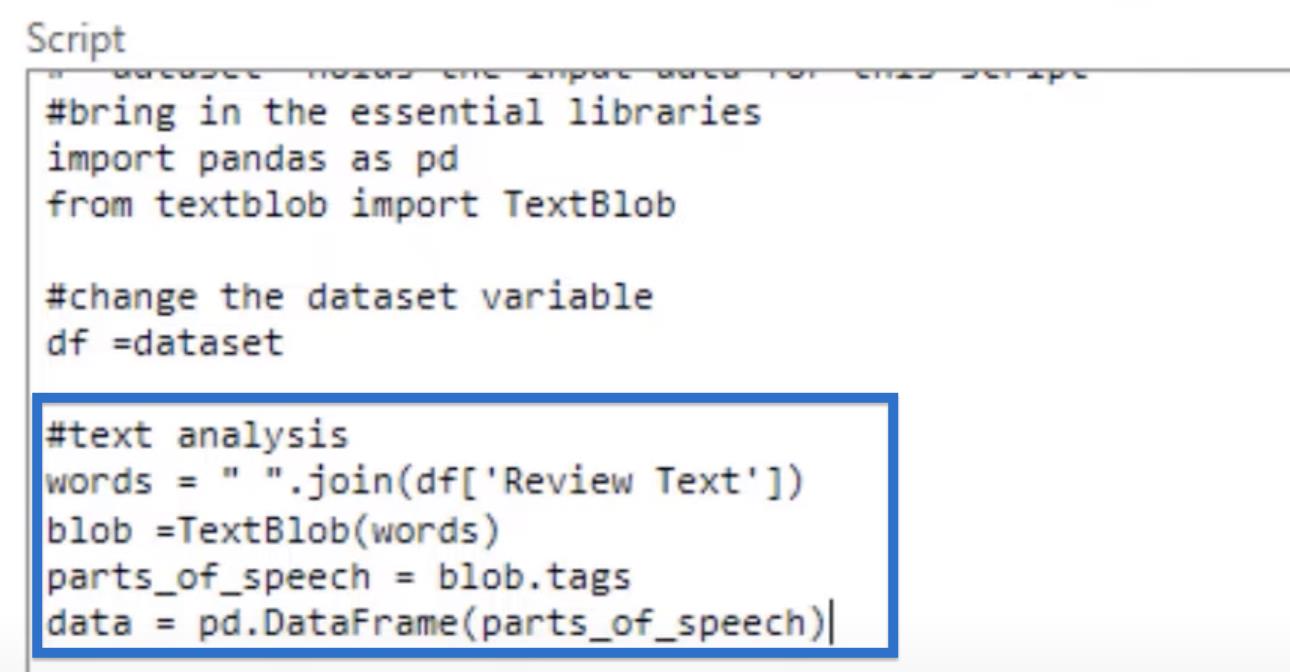

La oss ta inn to pakker for vår Python-tekstanalyse ved hjelp av editoren vår. Vi vil "importere pandaer som pd" , vårt datamanipuleringsbibliotek som skal lagres som variabel pd. Og så " fra tekstblob " , vil vi " importere TextBlob " med stor bokstav mellom ordene.

Vi kan alltid dokumentere hva vi gjør ved å sette inn en dokumentstreng. La oss skrive #bring inn de essensielle bibliotekene på toppen av pakkene våre.

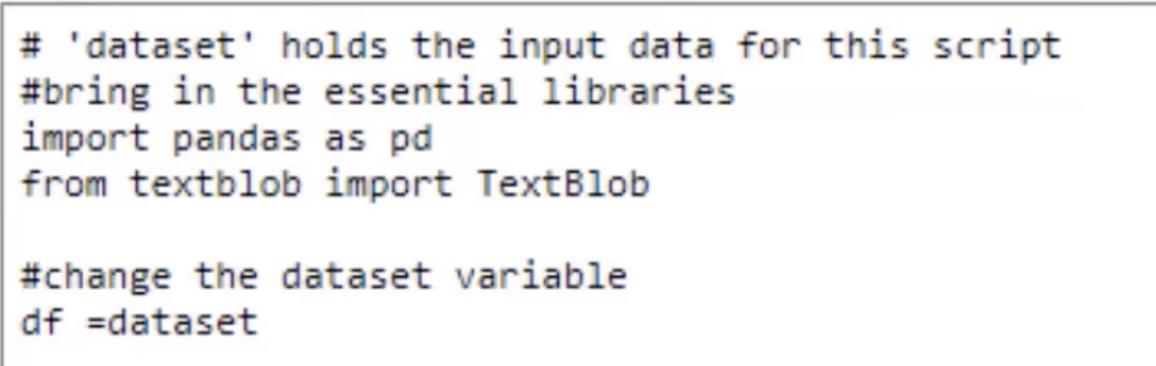

Gi nytt navn til variabelen

I den første linjen i skriptet vårt er det denne linjen levert av LuckyTemplates som sier at # 'datasett' inneholder inndataene for dette skriptet. Denne linjen sier at våre data kalles et datasett.

Så la oss endre det fordi det tar for lang tid å skrive "datasett". Skriv inn #endre datasettvariabelen og df = datasett på neste linje.

Nå er det kortere å skrive variabelen vår.

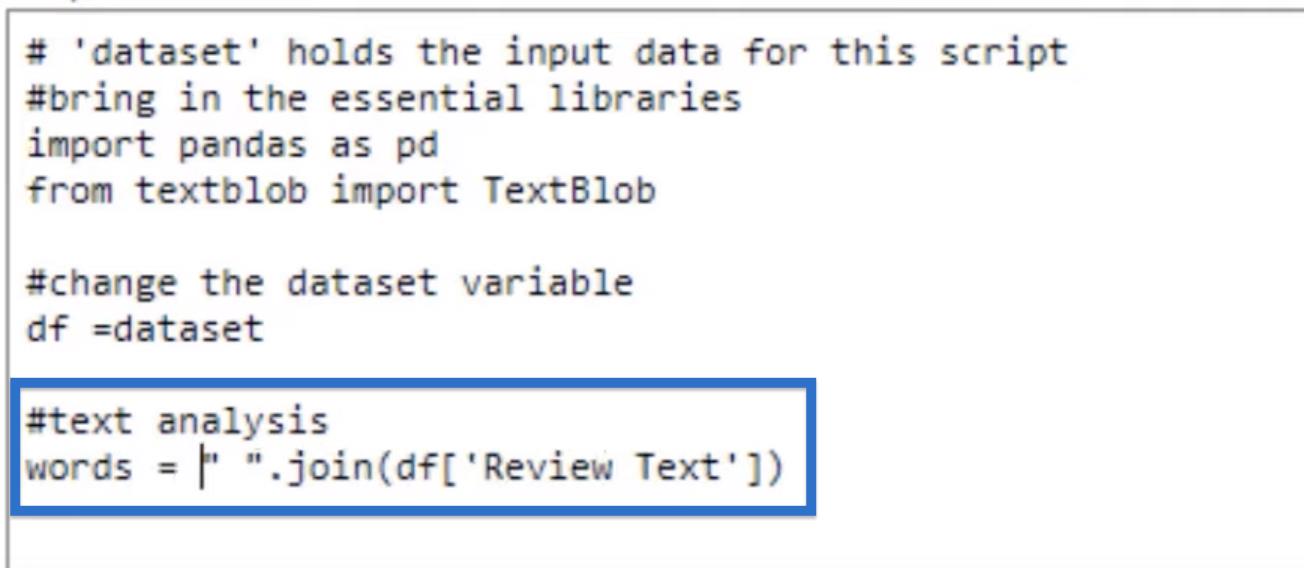

Gjør tekstanalysen

La oss fortsette med tekstanalysen vår. Husk at våre anmeldelsestekster er i en kolonne med individuelle celler. Dette oppsettet er egentlig ikke nyttig for oss fordi vi vil ha alle tekstene samlet slik at vi kan utføre en analyse på den.

Vi vil imidlertid ikke at de skal slås sammen uten mellomrom, så la oss starte koden vår med et mellomrom innenfor et dobbelt anførselstegn .

La oss deretter legge til .join og isolere vår gjennomgangstekstkolonne ved å bruke vår df- variabel, som inneholder datasettet. Skriv "Review Text" plassert inne i en parentesnotasjon som isolerer kolonnen.

Denne koden vil slå sammen alt, men vi må lagre den, så la oss lage en variabel kalt ord.

Når vi har samlet alle ordene, kan vi bruke tekstklatten vår til å begynne å analysere ordene.

Den første tingen å gjøre er å lage våre deler av tale ved å bruke blob- variabelen som vi trenger for å dele ut ord til en tekst-blob. Vi skal bruke den tekstklatten og pass i teksten, som er ordene våre . Dette skrives som blob = TextBlob(ord).

Nå som vi har den bloben, tar vi den og lager vår parts_of_speech- variabel ved å bruke blob.tags . Taggene vil være forkortelsene for hver enkelt del av tale.

Det vi skal gjøre videre er å lagre dette som en dataramme ved å bruke Pandaer som vi tok inn. La oss kalle det dataene våre som er lik pd.DataFrame og vi bringer inn våre parts_of_speech .

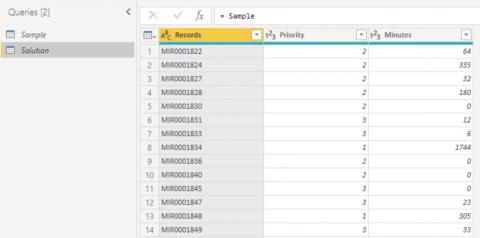

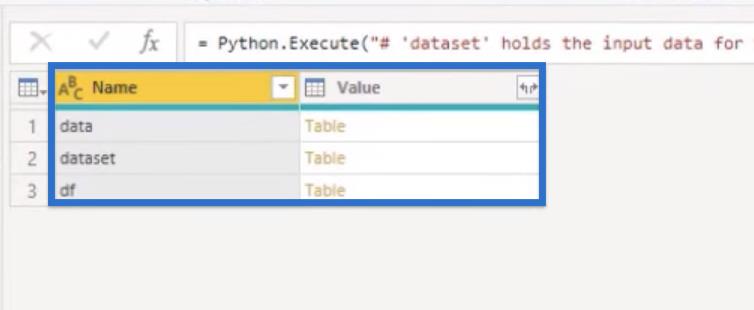

La oss klikke OK for å kjøre koden vår. Etter å ha kjørt koden vår, bør vi få en tabell over variablene våre. Vi har datasettet eller våre originale data. Vi har også våre data og df .

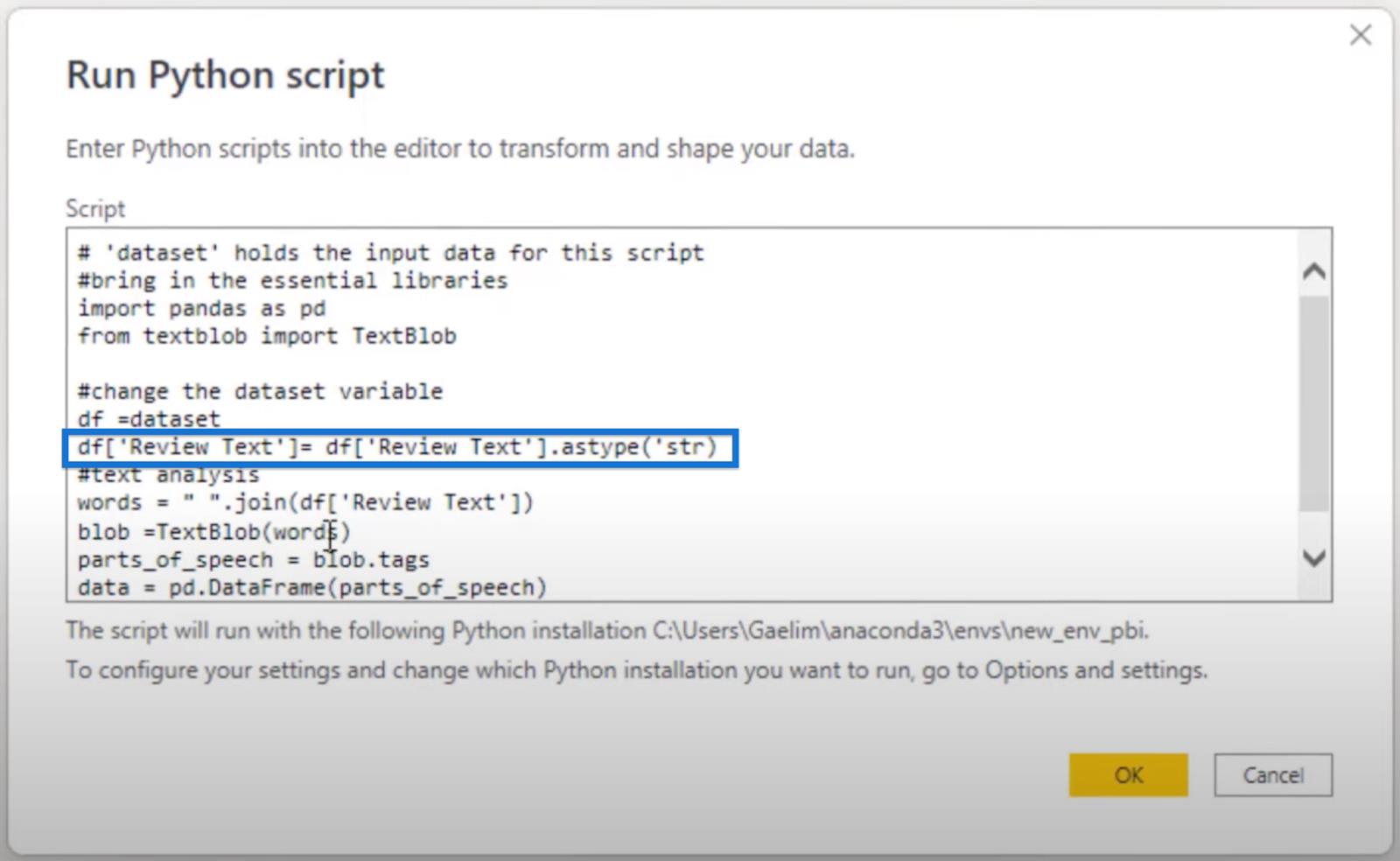

Hvis du ikke fikk de tiltenkte resultatene, viser vi deg de forskjellige måtene å unngå noen feil som du kan få i koden.

Fikser koden for tekstanalyse i Python

Noen ganger må vi kanskje være veldig eksplisitte når det gjelder å endre formatet på teksten vi er opptatt av.

Vi kan gjøre det ved å kalle opp df -variabelen vår, isolere 'Review Text ' plassert i en parentesnotasjon, og deretter endre typen til strenger ved å bruke .astype('str') . Så er det bare å lagre dette på nytt i df -variabelen.

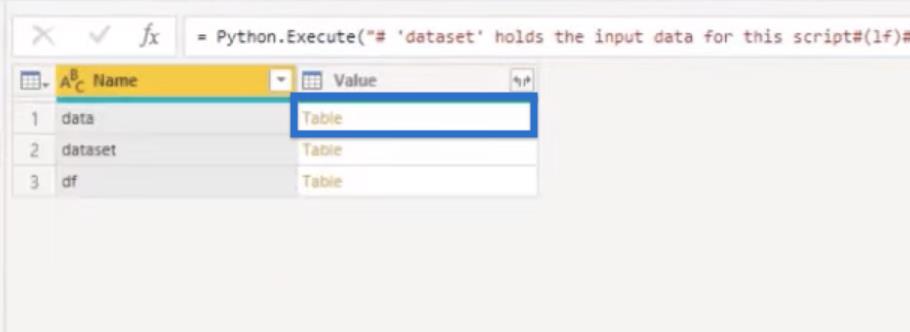

Klikk OK for å kjøre koden på nytt. Vi bør få de samme resultatene som vi fikk tidligere.

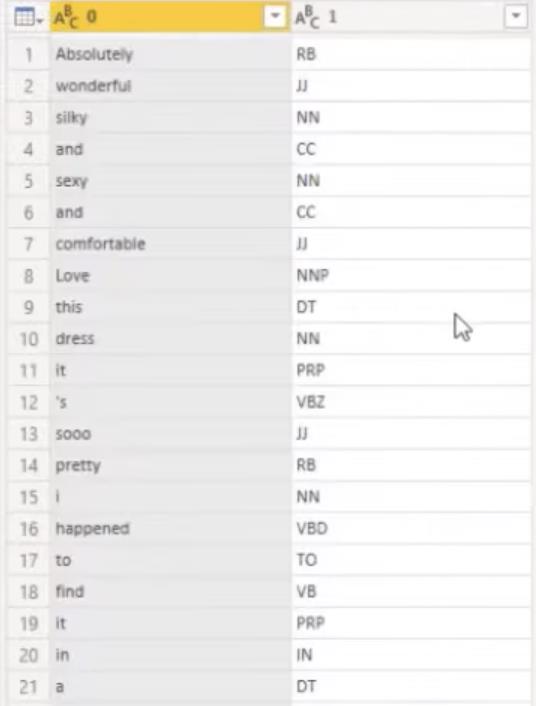

Nå vil vi åpne dataene våre , den siste variabelen vi tok inn for å se hvordan den ser ut.

Vi bør ha alle ordene våre brutt opp av deler av tale. Vi har ikke navngitt kolonnene våre ennå, men vi kan enkelt gjøre det.

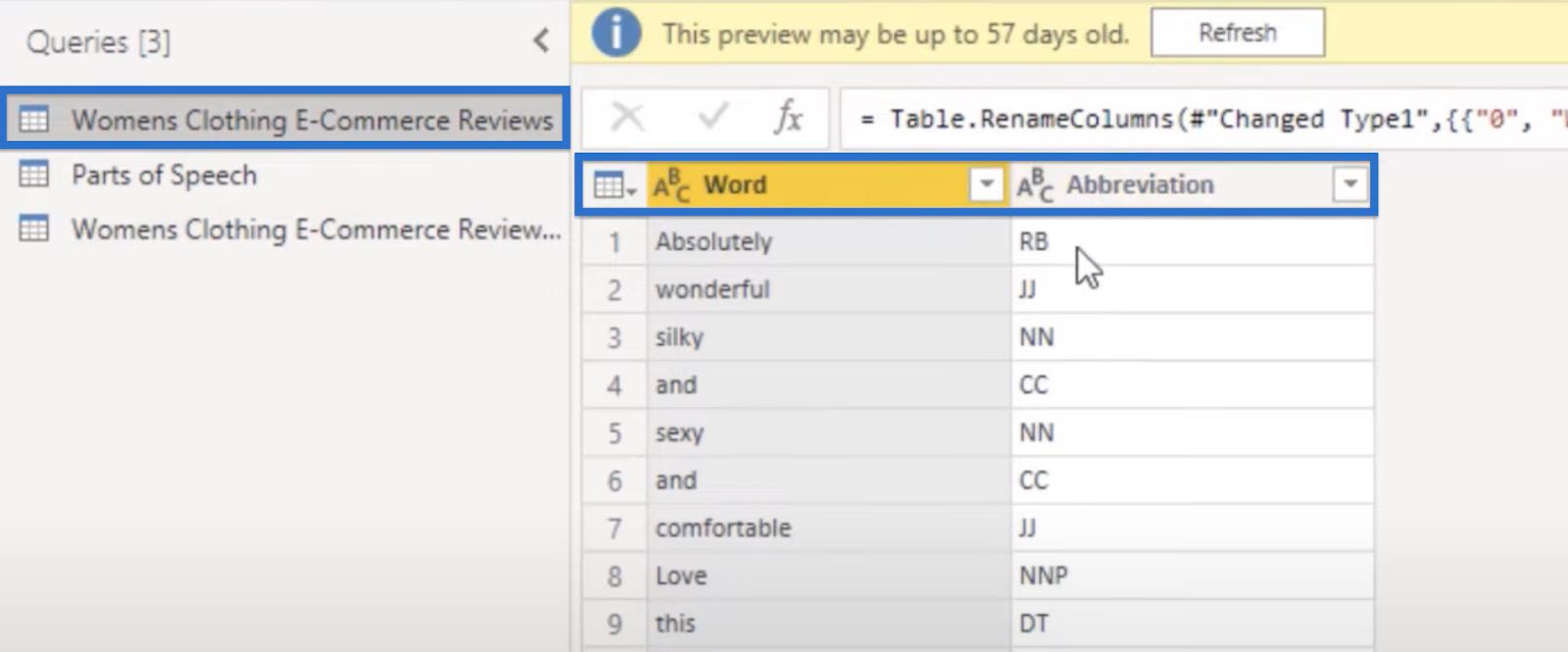

I den gamle versjonen av denne samme tekstanalysen kalte jeg den første kolonnen som Word og den andre som forkortelse .

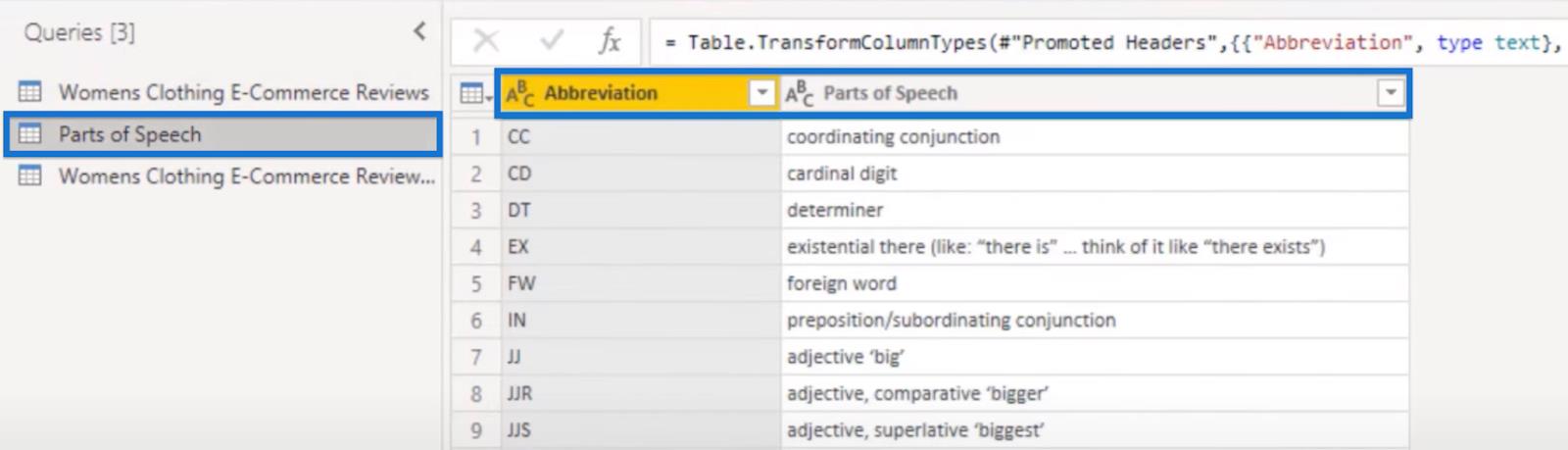

I Parts of Speech- spørringen tar vi inn de faktiske ordene som er for disse forkortelsene og kobler dem alle sammen.

La oss nå lukke og bruke .

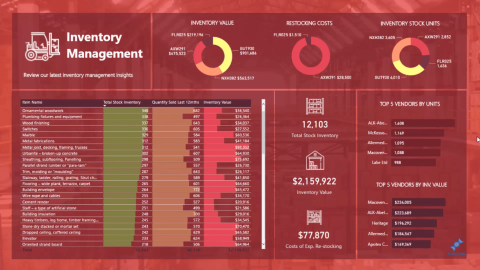

Trinnene vi gjorde, tillot oss å filtrere gjennom de forskjellige delene av tale som vi identifiserte ved hjelp av en enkel kode. Det gir oss dette visuelle bildet i LuckyTemplates der vi enkelt kan filtrere teksten vår basert på hvilke deler av talekategorien de faller inn under.

Konklusjon

Som , kan du komme over behovet for å trekke ut innsikt og mening fra store mengder ustrukturerte tekstdata. Det du lærte er en nyttig tilnærming til å forstå tekstdata gjennom tekstanalyse.

Nå kan du enkelt bryte ned tekst i mindre enheter som ord og setninger, og deretter analysere disse enhetene for mønstre og sammenhenger. Du kan oppnå alle disse målene ved å bruke tekstanalyse i Python og LuckyTemplates.

Beste ønsker,

Lær å bruke DAX Studio EVALUATE nøkkelordet med grunnleggende eksempler og få en bedre forståelse av hvordan dette kan hjelpe deg med databehandling.

Finn ut hvorfor det er viktig å ha en dedikert datotabell i LuckyTemplates, og lær den raskeste og mest effektive måten å gjøre det på.

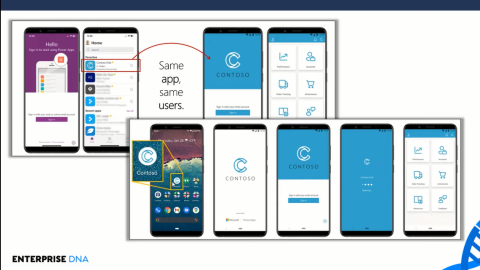

Denne korte opplæringen fremhever LuckyTemplates mobilrapporteringsfunksjon. Jeg skal vise deg hvordan du kan utvikle rapporter effektivt for mobil.

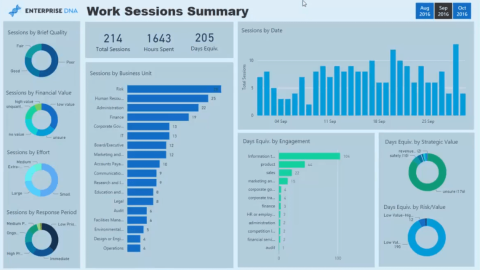

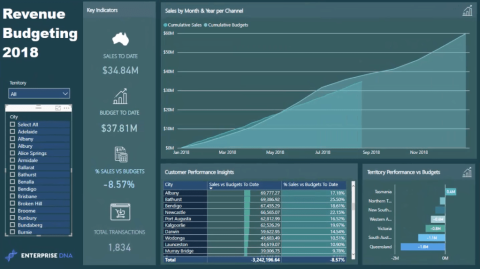

I denne LuckyTemplates-utstillingen vil vi gå gjennom rapporter som viser profesjonell tjenesteanalyse fra et firma som har flere kontrakter og kundeengasjementer.

Gå gjennom de viktigste oppdateringene for Power Apps og Power Automate og deres fordeler og implikasjoner for Microsoft Power Platform.

Oppdag noen vanlige SQL-funksjoner som vi kan bruke som streng, dato og noen avanserte funksjoner for å behandle eller manipulere data.

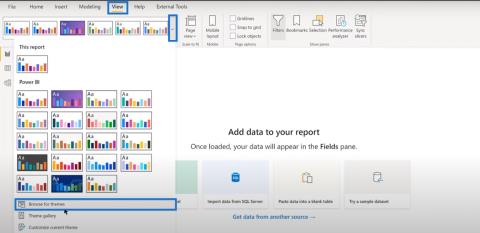

I denne opplæringen lærer du hvordan du lager din perfekte LuckyTemplates-mal som er konfigurert til dine behov og preferanser.

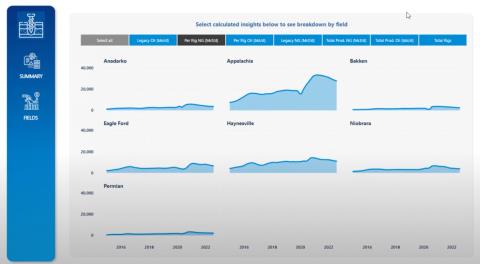

I denne bloggen vil vi demonstrere hvordan du legger feltparametere sammen med små multipler for å skape utrolig nyttig innsikt og grafikk.

I denne bloggen vil du lære hvordan du bruker LuckyTemplates rangering og tilpassede grupperingsfunksjoner for å segmentere et eksempeldata og rangere det i henhold til kriterier.

I denne opplæringen skal jeg dekke en spesifikk teknikk rundt hvordan du viser kumulativ total kun opp til en bestemt dato i grafikken i LuckyTemplates.