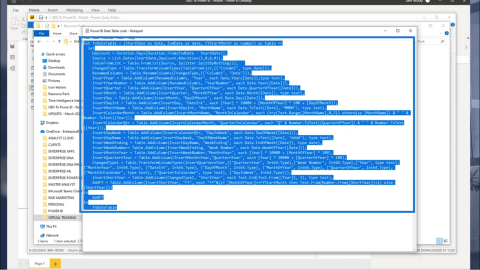

DAX Studio EVALUATE Nøkkelord: Grunnleggende eksempler

Lær å bruke DAX Studio EVALUATE nøkkelordet med grunnleggende eksempler og få en bedre forståelse av hvordan dette kan hjelpe deg med databehandling.

I denne bloggen skal vi diskutere tekstanalyse i Python for å lage konstruerte data fra tekstinnhold. Dette vil hjelpe deg med å analysere store mengder data og bruke mindre tid på å jobbe med visse oppgaver. Du vil også tilegne deg kunnskap om tekstblob som omhandler naturlig språkbehandlingsoppgaver.

Tekstanalyse er prosessen med å analysere tekster ved å bruke koder for automatiserte prosesser for å produsere og gruppere tekstdata.

Før vi fortsetter, må du kanskje installere biblioteket som vi skal bruke i denne opplæringen.

Innholdsfortegnelse

Implementering av tekstanalyse i Python

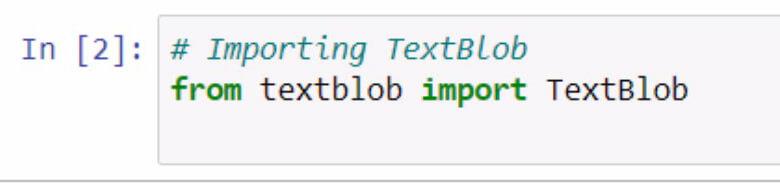

La oss begynne med å importere textblob . Husk å dokumentere hva du gjør med bruken av kommentarer.

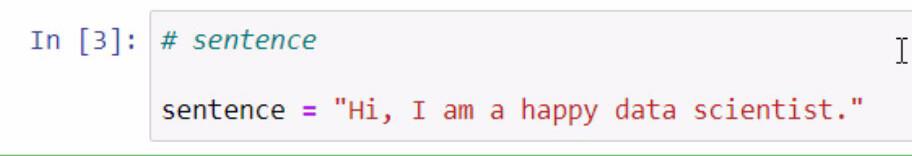

Ved å kjøre koden ovenfor har vi nå tilgang til textblob- biblioteket. Det neste trinnet vi skal gjøre er å lage en setning som vi skal bruke for våre eksempler. Vi skal gjøre dette ved å lagre en setning i en variabel kalt setning .

Husk å omslutte setningen du vil legge til med doble anførselstegn.

Textblobben er et flott bibliotek der vi kan lage en blob og bruke noen av funksjonene til tekstanalysen vår i .

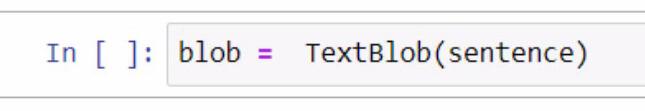

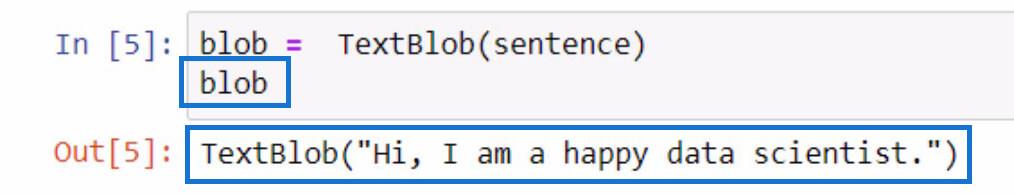

Når vi lager bloben, starter vi med å lage en variabel og gi den navnet blob . I denne variabelen må vi legge til TextBlob som er biblioteket vi bruker.

Innenfor parentesene bruker vi setningsvariabelen som inneholder setningen vi opprettet tidligere. Vær oppmerksom på at du kan velge å manuelt skrive selve setningen innenfor parentesen for denne delen.

For å sjekke hva denne blob- variabelen gjør, kan du ganske enkelt initialisere den ved å skrive inn variabelnavnet og trykke på Shift + Enter-tastene. Utdataene skal være lik eksemplet nedenfor.

Som du kan se av resultatet, er setningen som vi lagret i setningsvariabelen nå inneholdt av TextBlob .

Tokenisering av tekstdata i Python

Hvis du vil fjerne noen ord i en setning, kan vi dele hvert av disse ordene i individuelle deler i en liste. Med denne gitte setningen, er det vi skal gjøre tokenize dem eller skille hvert ord og sette det i en liste.

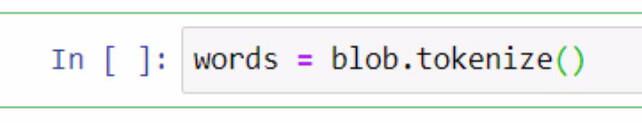

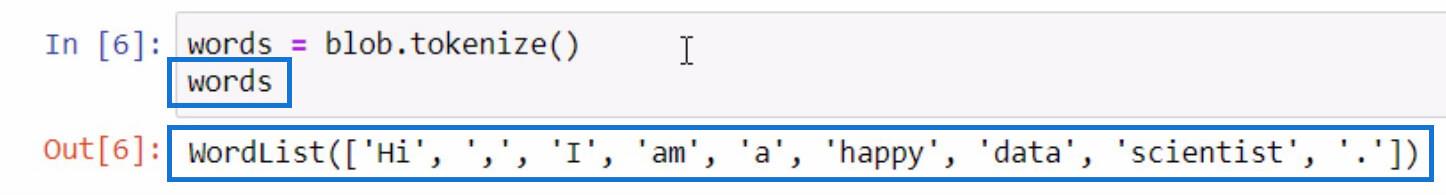

For å gjøre dette, skal vi bruke blob- variabelen og bruke tokenize- funksjonen. Deretter lagrer vi det i en variabel kalt ord .

La oss initialisere ordvariabelen på samme måte som vi gjorde ved initialisering av blob- variabelen for å se hva som er i den tokeniserte listen.

Som du kan se, er hvert av ordene, og til og med skilletegnene nå atskilt i en liste. Dette er hvordan tokenize- funksjonen fungerer.

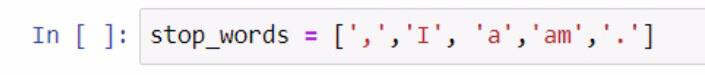

Nå som vi har en liste med ord, kan vi utføre en annen funksjon fra den. La oss lage en annen liste over ord som vi ikke ønsker skal inkluderes i listen vår, som tegnsetting og artikler. For å utføre dette trinnet, se skjermbildet nedenfor.

Når vi opprettet listen over stoppord, brukte vi parenteser for å omslutte listen over stoppord. Deretter er hvert av stoppordene omsluttet av enkle anførselstegn og atskilt med komma. Vi lagret listen i stop_words- variabelen.

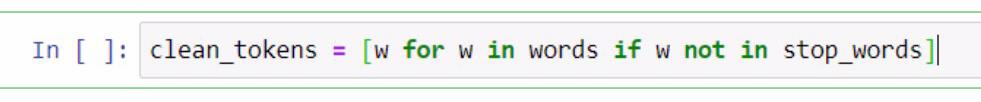

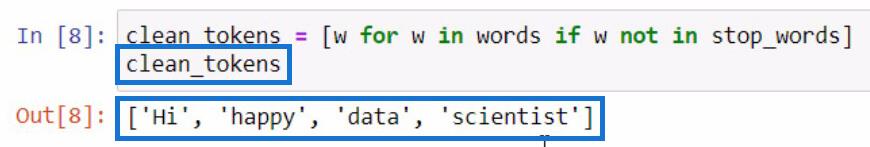

Herfra skal vi utføre en listeforståelse for å fjerne ord som er nødvendige for å utføre tekstanalyse i . Dette inkluderer rengjøring av setninger, tokenisering og sammenligning av forskjellige lister. Vi skal nå sammenligne disse to listene og lage en ny liste over clean_tokens .

I koden presentert ovenfor brukte vi en plassholder som er w for å representere et element . Det vi prøver å gjøre i denne delen er å få elementet i ordvariabelen hvis elementet ikke eksisterer i stop_words -variabelen. Hvis vi skal initialisere clean_tokens , vil dette være resultatet.

I denne prosessen er vi i stand til å rense tokenene våre ved å sette inn en prosess for å fjerne unødvendige tokens som tegnsetting og artikler. På grunn av det har vi bare essensordene igjen på listen vår.

Å bli med tokens for å danne en setning i Python

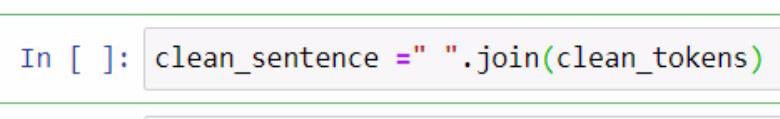

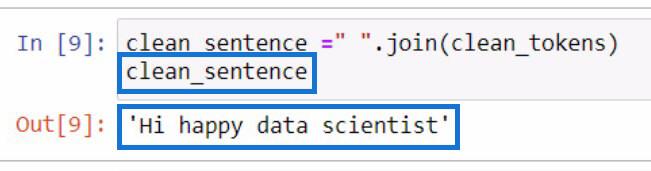

Nå som vi har skilt de rene tokenene , la oss prøve å sette dem sammen i én setning. For å gjøre det, må vi bruke .join- funksjonen. Sjekk eksemplet nedenfor for referanse.

I eksemplet ovenfor opprettet vi en variabel kalt clean_setence for å holde våre rene tokens som vil bli kombinert til en setning. Du kan også legge merke til at vi har lagt til et mellomrom omsluttet av doble anførselstegn og .join -funksjonen. Inne i parameterne inkluderte vi clean_tokens- variabelen.

Dette vil være utdata hvis vi initialiserer clean_setence- variabelen.

Merkbart at setningen ikke ser riktig ut fordi vi fjernet artiklene og tegnsettingene tidligere.

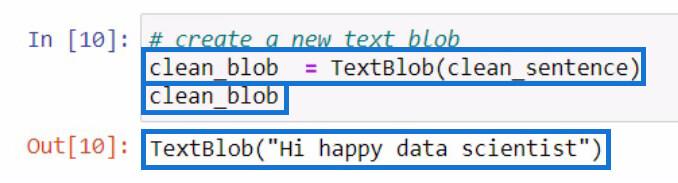

Etter å ha opprettet clean_setence , la oss prøve å lage en ny tekstblob som inneholder clean_setence som vi nettopp opprettet. Så lagrer vi det i en ny variabel clean_blob .

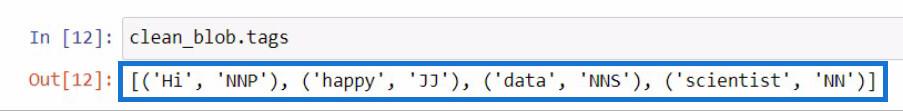

Dissekere en tekstblob for deler av tale ved å bruke .tags-funksjonen

Fra denne analyseklatten kan vi bruke delene av denne klatten til å se etter deler av tale eller gjøre enda flere endringer. La oss prøve å sjekke orddelene til hvert ord i den nye tekstblobben vår .

For å sjekke orddelene i en tekstblob, bør du bruke .tags- funksjonen. Jeg gjorde dette ved å bruke vår clean_blob- variabel, så la jeg til .tags- funksjonen rett etter.

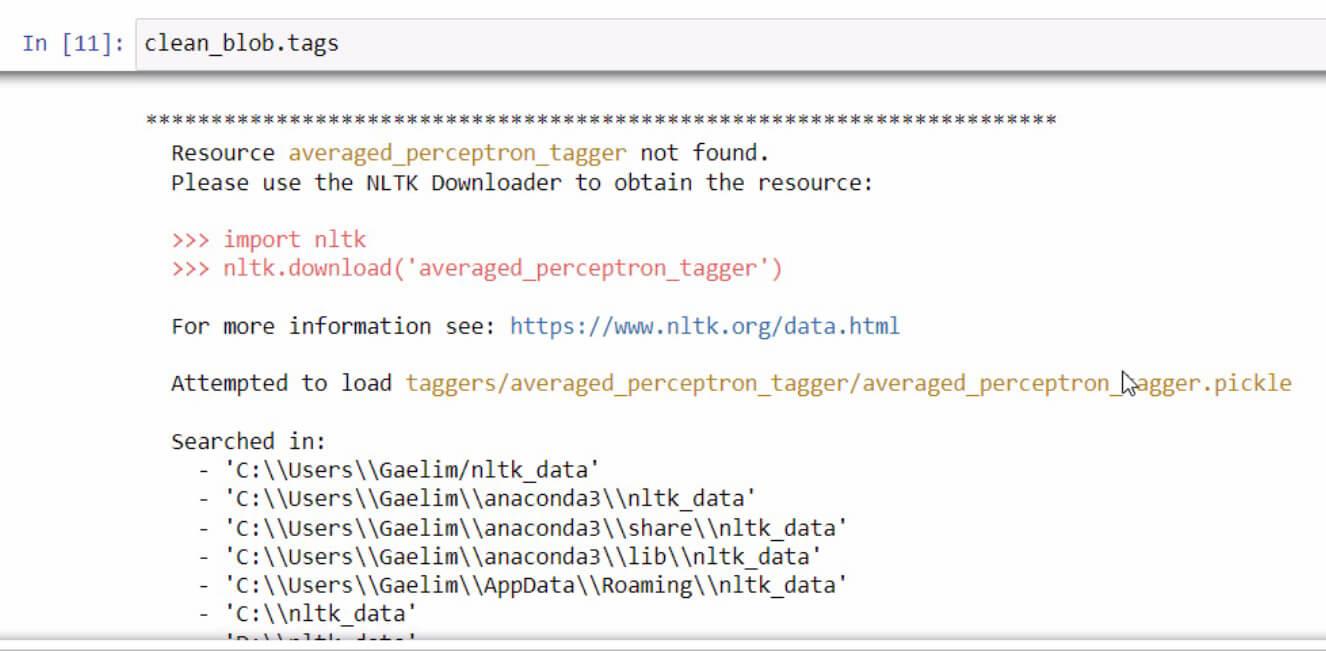

Hvis du noen gang får en feilmelding ved initialisering av .tags- funksjonen, er det bare å lese og følge trinnene for å fikse feilen. I dette tilfellet ser det slik ut.

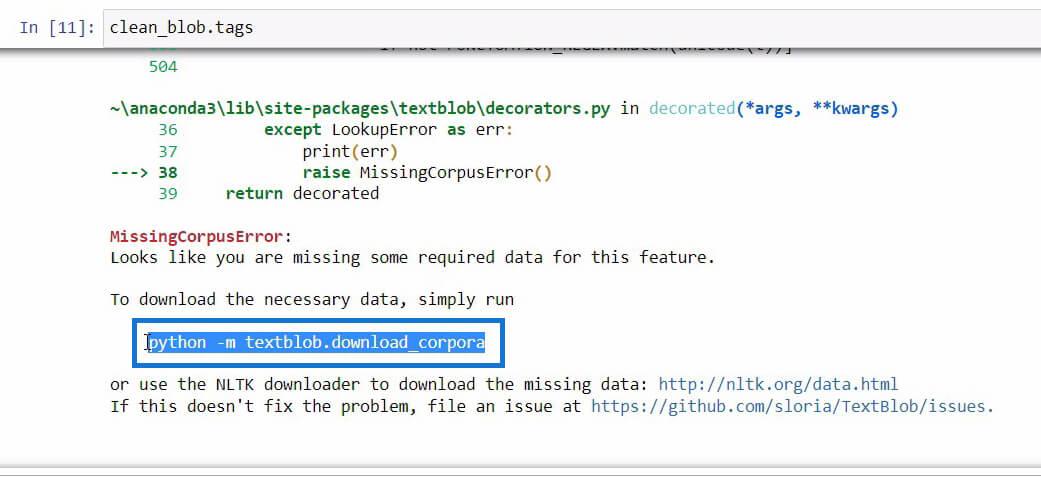

Hvis du blar ned på slutten av denne feilmeldingen, vil du se de nødvendige dataene du trenger for funksjonen du prøver å bruke.

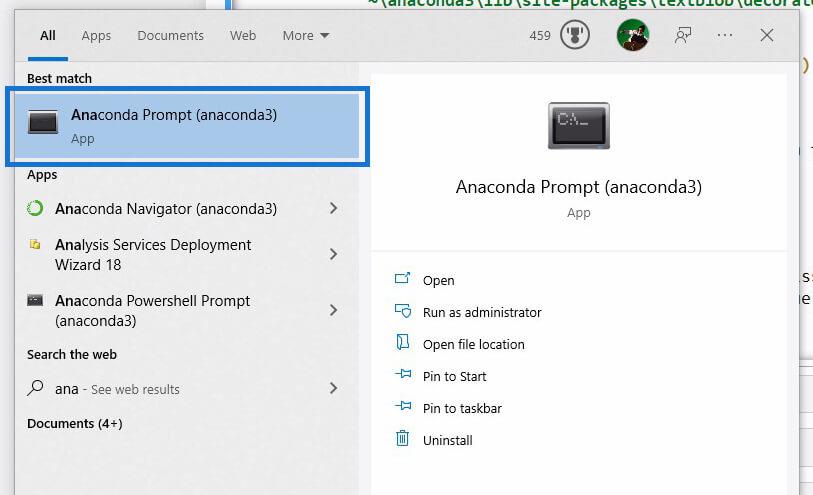

Når vi har funnet koden som vi må initialisere for å laste ned de nødvendige dataene, kopierer du bare koden og åpner deretter med Windows Search .

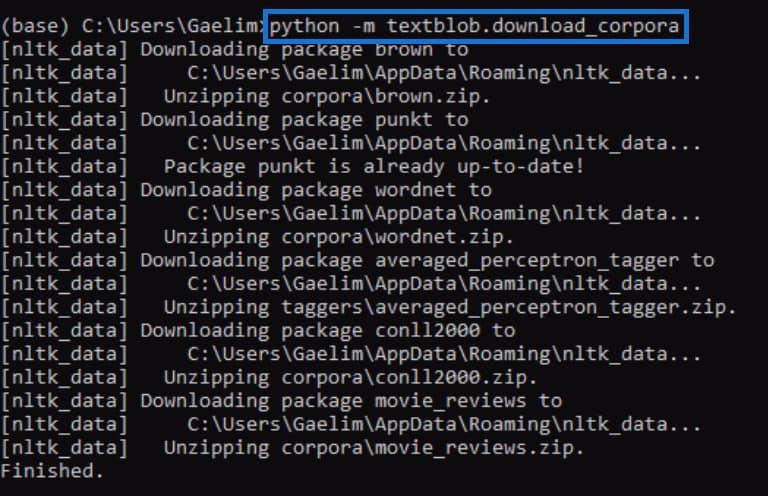

Ved å bruke Anaconda-prompt vil vi prøve å fikse feilen vi mottok ved initialisering av .tags- funksjonen. Vi limer nå inn koden som vi kopierte fra feilmeldingen tidligere og kjører den ved å trykke Enter .

Når den er ferdig, prøv å kjøre .tags- funksjonen igjen og se om den fungerer.

Når vi kjører koden på nytt, kan vi se at feilen er rettet og vi mottok et resultat som inneholder hvert ord fra den nye tekstblobben sammen med kodene eller deler av tale.

Hvis du ikke aner hva disse kodene betyr, kan du ganske enkelt gå til tekstblob-nettstedet for å sjekke hva disse kodene representerer.

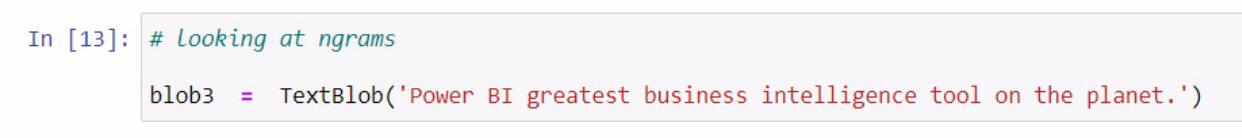

Bruke ngrams-funksjonen for tekstanalyse i Python

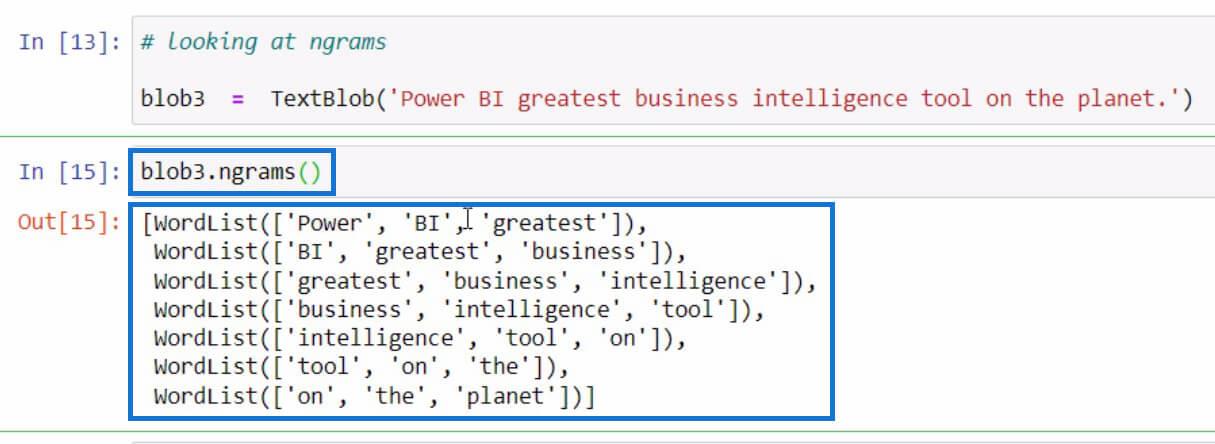

La oss gå til et annet eksempel, som handler om å få ngrammene . ngrams - funksjonen brukes til å lete etter ord som ofte sees sammen i en setning eller et dokument. Som et eksempel, la oss starte med å lage en ny tekstblob og lagre den i blob3- variabelen.

Etter det, la oss bruke ngrams- funksjonen i blob3- variabelen for å sjekke noen kombinasjoner av ord.

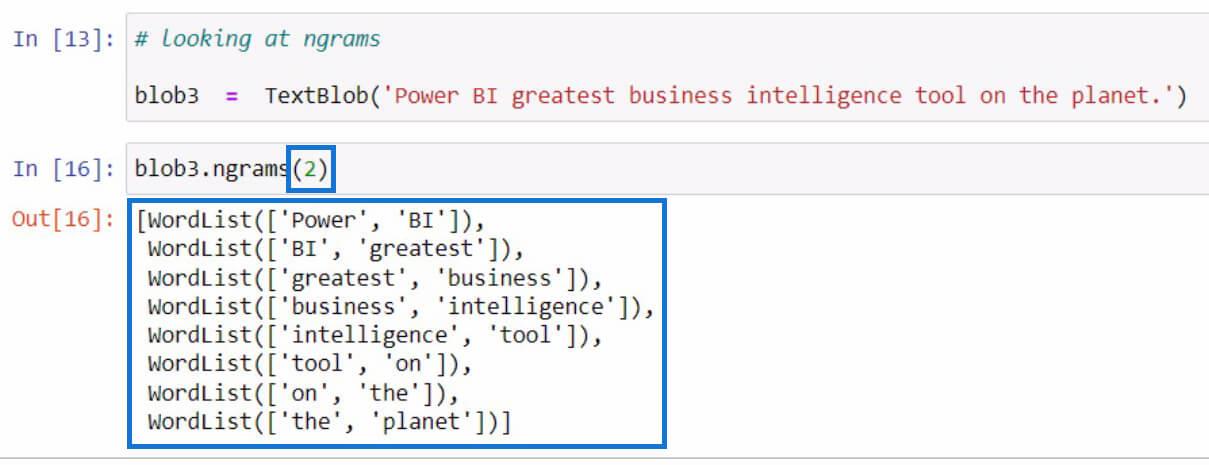

Som standard, hvis du ikke spesifiserte en verdi i parameterne, vil den vise trigrammer eller 3-ordskombinasjoner. Men hvis vi ønsker å se 2-ords kombinasjoner fra setningen, kan vi sette 2 i parameterne som i eksemplet nedenfor.

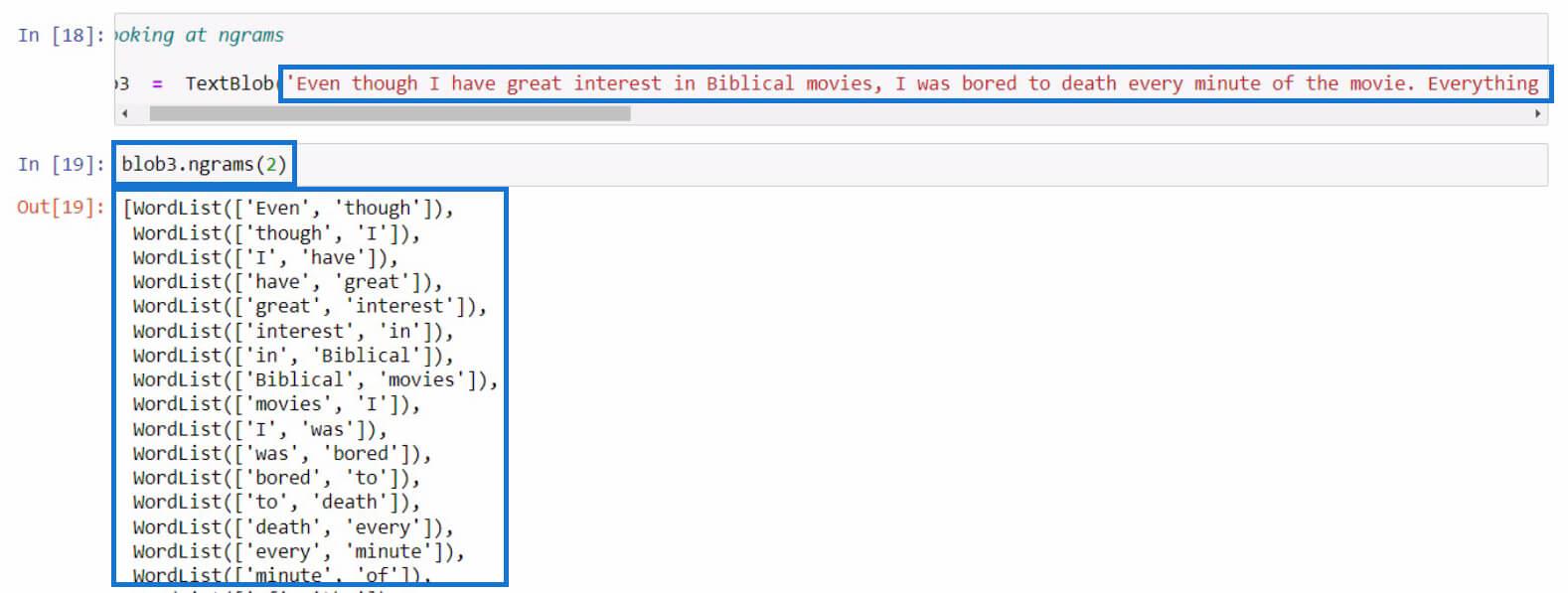

La oss prøve det med en lengre setning denne gangen. I dette eksemplet kopierte jeg nettopp en lengre tekst fra en filmanmeldelse. Du kan bruke hvilken som helst setning du vil for denne delen.

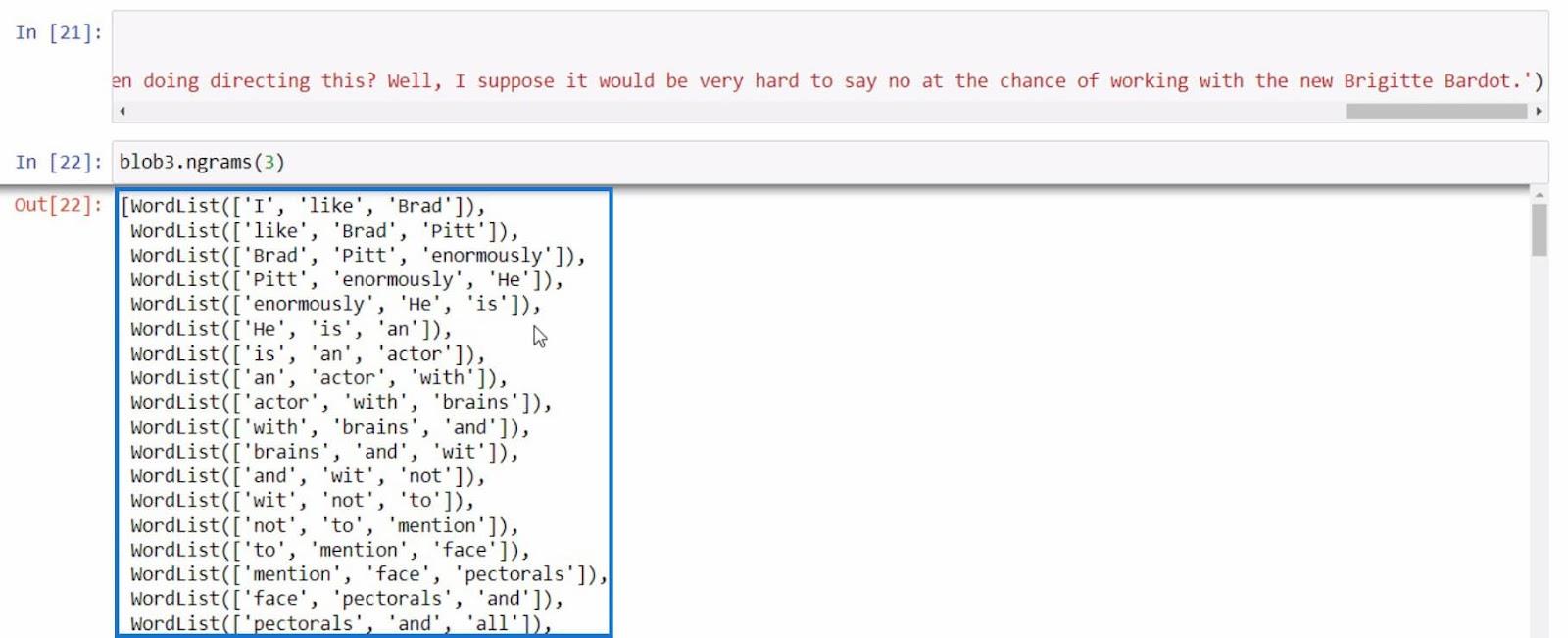

Som et siste eksempel, la oss prøve å bruke ngrams én gang til med en mer informativ setning.

Med alle disse eksemplene kan vi utføre mer tekst basert på resultatene vi får med ngrams -funksjonen.

Konklusjon

For å oppsummere har du lært om de forskjellige funksjonene du kan bruke for å utføre tekstanalyse i Python.

Dette er .tokenize-funksjonen for å skille ord i en setning, .join-funksjonen for å kombinere tokeniserte ord, .tags-funksjonen for å sjekke orddelene og ngrams-funksjonen for å se kombinasjonen av ord.

I tillegg har du lært hvordan du kan fikse feil som det vi gjorde i .tags- funksjonen ved å bruke Anaconda-prompt . Du har også lært hvordan du importerer, lager en tekstblob og bruker dette biblioteket til å utføre tekstanalyse i .

Beste ønsker,

Gaellim

Lær å bruke DAX Studio EVALUATE nøkkelordet med grunnleggende eksempler og få en bedre forståelse av hvordan dette kan hjelpe deg med databehandling.

Finn ut hvorfor det er viktig å ha en dedikert datotabell i LuckyTemplates, og lær den raskeste og mest effektive måten å gjøre det på.

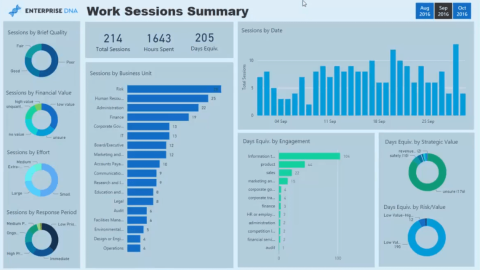

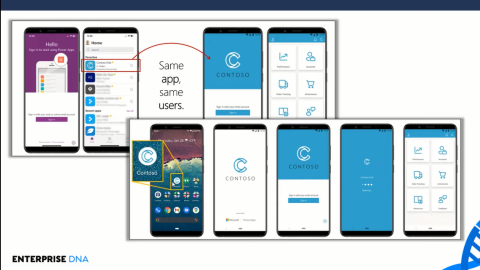

Denne korte opplæringen fremhever LuckyTemplates mobilrapporteringsfunksjon. Jeg skal vise deg hvordan du kan utvikle rapporter effektivt for mobil.

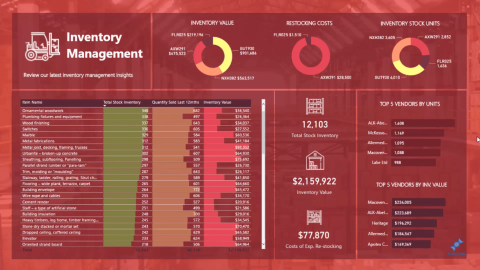

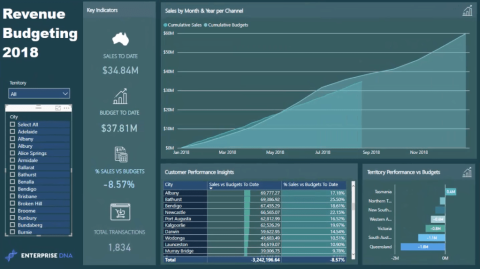

I denne LuckyTemplates-utstillingen vil vi gå gjennom rapporter som viser profesjonell tjenesteanalyse fra et firma som har flere kontrakter og kundeengasjementer.

Gå gjennom de viktigste oppdateringene for Power Apps og Power Automate og deres fordeler og implikasjoner for Microsoft Power Platform.

Oppdag noen vanlige SQL-funksjoner som vi kan bruke som streng, dato og noen avanserte funksjoner for å behandle eller manipulere data.

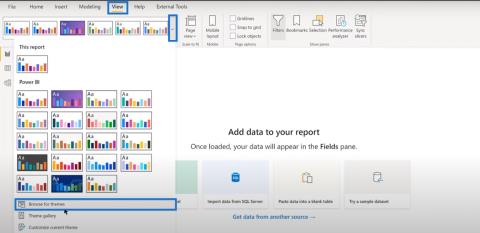

I denne opplæringen lærer du hvordan du lager din perfekte LuckyTemplates-mal som er konfigurert til dine behov og preferanser.

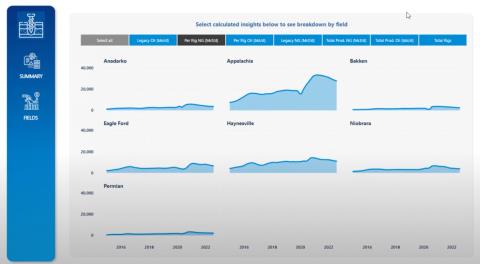

I denne bloggen vil vi demonstrere hvordan du legger feltparametere sammen med små multipler for å skape utrolig nyttig innsikt og grafikk.

I denne bloggen vil du lære hvordan du bruker LuckyTemplates rangering og tilpassede grupperingsfunksjoner for å segmentere et eksempeldata og rangere det i henhold til kriterier.

I denne opplæringen skal jeg dekke en spesifikk teknikk rundt hvordan du viser kumulativ total kun opp til en bestemt dato i grafikken i LuckyTemplates.