Her er et typisk dataanalysespørgsmål, vi får fra tid til anden:

Jeg har et regneark med over 100.000 rækker Excel-regneark, der har en masse kundeoplysninger, som jeg skal rydde op for dubletter. Jeg vil vurdere, at det vil tage mig et par dage at skrubbe listen manuelt. En kollega fortalte mig, at jeg sandsynligvis skal bruge en Excel-makro for at få det gjort. Vores IT-mand, som er fortrolig med makroudvikling, er på orlov, så jeg skal løse dette på egen hånd. Er der en måde at løse dette problem på uden at vide, hvordan man programmerer?

Ja, der er en måde at løse dette på i Excel, og det kræver ikke at være dygtig til Visual Basic-programmering. Lad os gå videre og løse dette hurtigt for dig.

Slet Excel-duplikerede rækker

Sådan slipper du af med de unødvendige poster i dit regneark:

- Først skal du lave en kopi af din projektmappe, så du har en sikkerhedskopi, hvis noget går galt.

- Åbn derefter dit Excel-regneark.

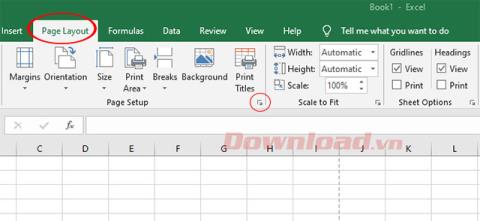

- I det øverste bånd skal du trykke på fanen Data .

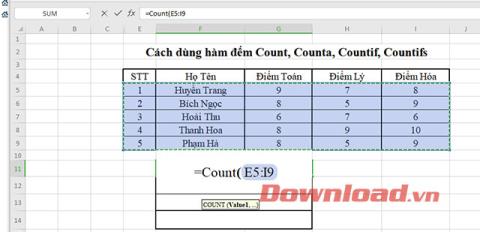

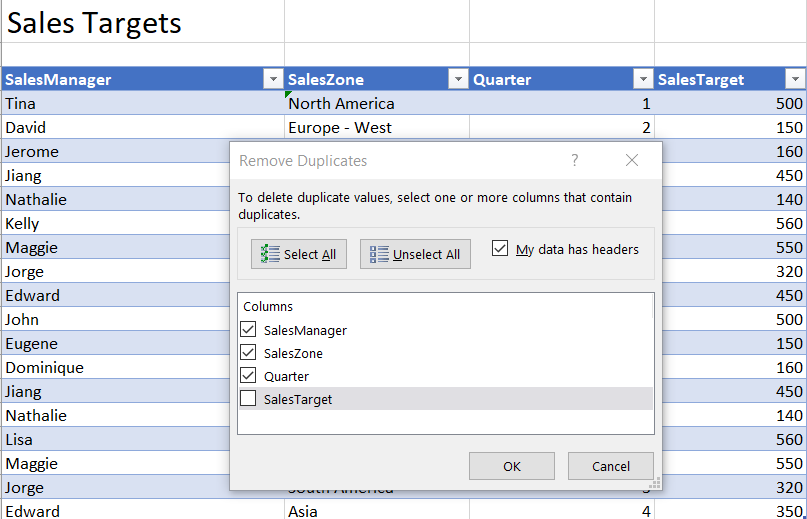

- Gå nu videre og vælg det dataområde, du gerne vil rydde op i. Sørg for, at du også vælger tabeloverskrifterne, hvis de er tilgængelige.

- I afsnittet Dataværktøjer skal du trykke på knappen Fjern dubletter .

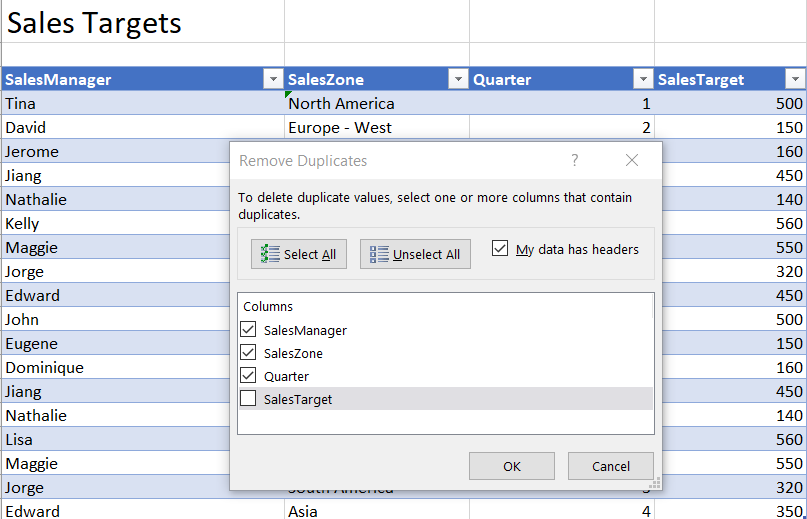

- Gå nu videre og tjek den relevante kolonne, der vil hjælpe dig med at afgøre, om en post på din liste er duplikeret. I vores tilfælde bruger vi vores demo-datasæt Salgsmål, og vi bruger de første 3 kolonner til at identificere duplikerede rækker.

- Tryk OK .

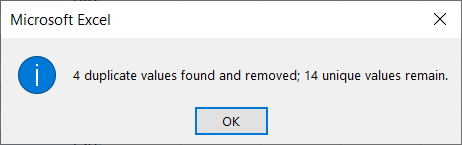

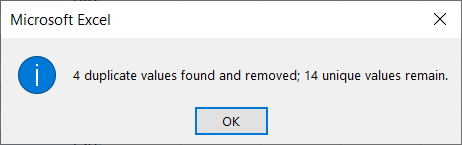

- En meddelelse med oplysninger om antallet af fjernede poster og dem, der er gemt i tabellen, vil blive vist.

- Tryk på OK og undersøg dit ændrede datasæt for korrekthed.

- Hvis du er tilfreds med resultatet, skal du gå videre og gemme din fil. Ellers kan du fortryde din ændring ( Rediger >> Fortryd ).

Avancerede tips:

- Tilsvarende kapacitet er tilgængelig i Excel PowerQuery, som giver dig mulighed for at transformere betydelige større datasæt.

- Hvis du er fortrolig med Python-sproget, kan du nemt slippe duplikerede rækker fra et datasæt ved hjælp af Pandas-biblioteket.

Nyd din dataanalyse 😉